Son aylarda yapay zeka alanındaki gelişmeler, özellikle de üretken video modelleri büyük ilgi görüyor. Bu modellerin, gerçek dünyanın fiziksel özelliklerini gösteren sınırlı bir bilgiyi ortaya koyma yetenekleri, yapay zekanın operasyonel kabiliyetlerinde önemli bir ilerleme olabilecek, "dünya modeli" olarak adlandırılan sağlam bir temel oluşturma potansiyeli taşıyor.

Google'ın DeepMind Araştırma ekibi, video modellerinin eğitim verilerinden gerçek dünya hakkında ne kadar iyi öğrenebildiğine bilimsel bir titizlikle yaklaşmaya çalıştı. "Video Modelleri Sıfır-Çekim Öğreniciler ve Akıl Yürütücüler" başlıklı makalede, araştırmacılar Google'ın Veo 3 modelini kullanarak, gerçek dünyayı algılama, modelleme, manipüle etme ve akıl yürütme ile ilgili onlarca görevi test etmek için binlerce video ürettiler.

Araştırmacılar, Veo 3'ün "açıkça eğitilmediği geniş bir görev yelpazesini çözebildiğini" ve video modellerinin "vizyon için birleşik, genel amaçlı temel modeller olma yolunda ilerlediğini" iddia ediyor. Ancak yapılan deneylerin sonuçlarına bakıldığında, araştırmacıların günümüzdeki video modellerini biraz esnek bir şekilde değerlendirdiği ve gelecekteki ilerlemelerin mevcut tutarsız sonuçları düzelteceğini varsaydığı görülüyor.

%8'lik Bir Başarı Notu mu?

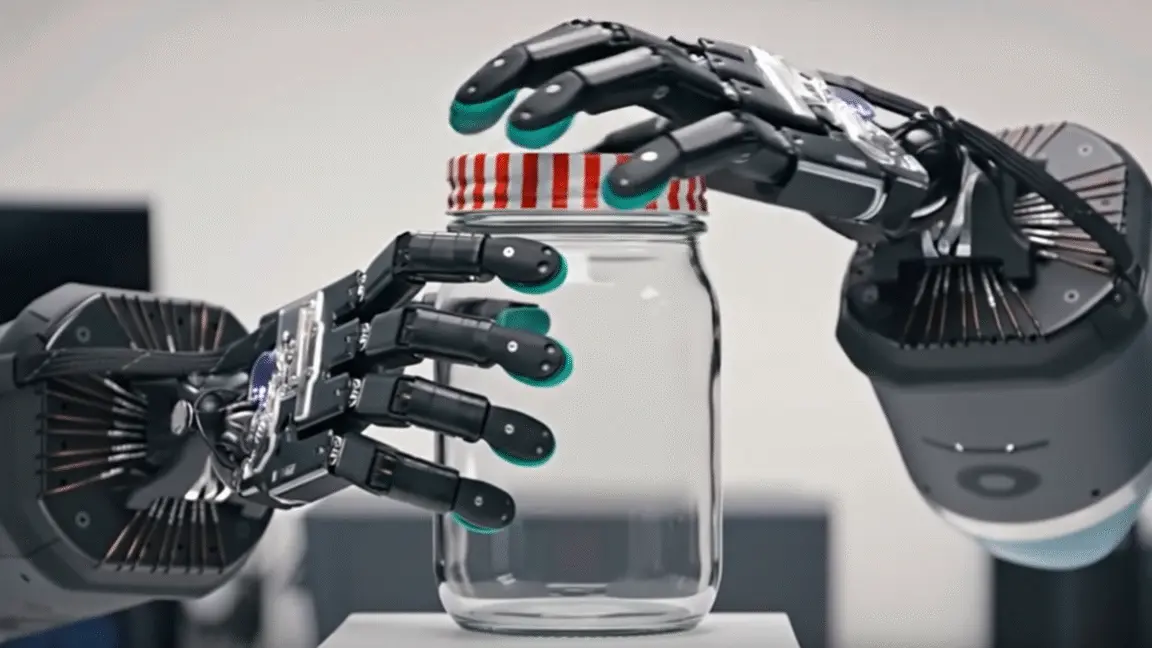

Elbette, Veo 3'ün test edilen onlarca görevden bazılarında etkileyici ve tutarlı sonuçlar elde ettiği doğrudur. Örneğin, robot ellerinin bir kavanozu açması veya bir topu atıp yakalaması gibi eylemlerin videolarını 12 denemede güvenilir bir şekilde üretebildi. Veo 3, görüntüleri bulanıklıktan arındırma, gürültüyü giderme, karmaşık görüntülerdeki boşlukları doldurma ve nesnelerin kenarlarını algılama gibi görevlerde de benzer şekilde kusursuz veya kusursuza yakın sonuçlar gösterdi.

Ancak diğer görevlerde, modelin çok daha değişken sonuçlar sergilediği görüldü. Örneğin, bir ızgara üzerindeki belirli bir yazılı karakteri vurgulayan bir video üretmesi istendiğinde, model 12 denemeden 9'unda başarısız oldu. Bir Bunsen bekinin açılıp bir kağıt parçasını yakmasını modellemesi istendiğinde de benzer şekilde 12 denemeden 9'unda başarısız oldu. Basit bir labirenti çözmesi istendiğinde 12 denemeden 10'unda, etiketli balonları sırayla patlatarak sayıları sıralaması istendiğinde ise 12 denemeden 11'inde başarısız oldu.

Araştırmacılar için bu örneklerin hiçbiri başarısızlık göstergesi değil, aksine modelin yeteneklerinin bir işareti olarak değerlendiriliyor. Makaledeki "başarısızlık durumları" altında listelenmek için Veo 3'ün test edilen 62 görevden 16'sında olduğu gibi, 12 denemenin tamamında başarısız olması gerekiyordu. Geri kalan görevler için araştırmacılar, "başarı oranının %0'dan büyük olması modelin görevi çözme yeteneğine sahip olduğunu gösteriyor" diye yazıyor.

Böylece, belirli bir görevde 12 denemenin 11'inde başarısız olmak, makalede modelin yetenekleri için bir kanıt olarak kabul ediliyor. Modelin "görevi çözme yeteneğine sahip olduğu"na dair bu kanıtlar arasında, modelin 12 deneme koşusunun yarısından fazlasında başarısız olduğu 18 görev ve denemelerin %25 ila %50'sinde başarısız olduğu 14 görev bulunuyor.

Geçmiş Sonuçlar, Gelecek Performans

Evet, tüm bu durumlarda model teknik olarak test edilen yeteneği bir noktada gösteriyor. Ancak modelin bu görevi güvenilir bir şekilde yerine getirememesi, pratikte çoğu kullanım durumu için yeterince performanslı olmayacağı anlamına geliyor. "Birleşik, genel amaçlı vizyon temel modelleri" haline gelebilecek herhangi bir gelecekteki modelin, bu tür testlerde çok daha tutarlı bir şekilde başarılı olması gerekecek.

Araştırmacılar Veo 3'ün performansının "henüz mükemmel olmadığını" kabul etmekle birlikte, gelecekteki video modellerinin "tıpkı LLM'lerin dil için olduğu gibi, vizyon için genel amaçlı temel modeller olacağına" dair işaretler olarak Veo 2'den Veo 3'e sürekli iyileşmeye dikkat çekiyorlar. Ve araştırmacıların bu argüman için bazı verileri de mevcut.

Örneğin, binlerce video üretiminde yapılan nicel testlerde, Veo 3 rastgele bir deseni yatay olarak %72 oranında yansıtabildi; bu oran Veo 2 için %0 idi. Veo 3, kenar tespiti, nesne çıkarma ve labirent çözme gibi görevlerde Veo 2'ye kıyasla daha küçük ama hala etkileyici tutarlılık iyileştirmeleri gösterdi.

Ancak denildiği gibi, geçmiş performans gelecekteki sonuçların göstergesi değildir. Mevcut bakış açımızdan, video modellerinin Veo 3 gibi üssel iyileşmeler görmeye hazır olup olmadığını veya bunun yerine azalan getiriler noktasına yaklaşıp yaklaşmadığını bilmek zor.

Yanlış bilgi üreten LLM'lerle (confabulating LLMs) deneyim, bir modelin bazen doğru sonuç üretmesi ile yükseltilmiş bir modelin her zaman doğru sonuç üretmesi arasında genellikle büyük bir boşluk olduğunu da gösterdi. Video modellerinin aynı temel komut verildiğinde ne zaman, neden ve nasıl başarısız olduğunu veya başarılı olduğunu anlamak önemsiz bir sorun değil ve gelecekteki modellerin yakında çözeceği bir sorun da değil.

Günümüzdeki üretken video modelleri ne kadar etkileyici olursa olsun, bu tür testlerde gösterilen tutarsız sonuçlar, dünya hakkında akıl yürütebildikleri söylenmeden önce hala uzun bir yol kat etmeleri gerektiğini kanıtlıyor.