Yapay zeka (YZ) alanındaki haberler genellikle büyük anlaşmalar ve milyarlarca dolarlık yatırımların yanı sıra donanım geliştirmelerine odaklanıyor. Ancak, YZ modellerinin gerçek dünyadaki performansını ve verimliliğini ölçen testler genellikle sadece donanıma odaklanmış durumda. SemiAnalysis tarafından geliştirilen açık kaynaklı InferenceMax AI benchmark süiti, bu boşluğu doldurmayı hedefliyor. Bu araç, YZ yazılım yığınlarının (yazılım ve donanım kombinasyonlarının) verimliliğini gerçek dünya çıkarım senaryolarında ölçüyor ve sonuçları düzenli olarak yayınlıyor.

Apache 2.0 lisansı altında sunulan InferenceMax, yüzlerce YZ hızlandırıcı donanım ve yazılım kombinasyonunun performansını sürekli olarak izliyor. Mevcut benchmark testlerinin belirli zaman noktalarındaki sonuçları sunduğunu ve yazılımdaki güncellemelerle gelen ilerlemeleri veya gerilemeleri tam olarak yansıtmadığını belirten proje, bu açığı kapatmayı amaçlıyor. Sürücülerden çerçevelere, modellerden diğer bileşenlere kadar tüm YZ yığınının evrimini takip etmeyi sağlıyor.

Benchmark, mümkün olduğunca tarafsız olacak şekilde ve gerçek dünya uygulamalarını taklit edecek biçimde tasarlanmış. Yalnızca mutlak performansa odaklanmak yerine, InferenceMax'in metrikleri projelerin önemsediği temel bir sayıyı hedefliyor: Toplam Sahiplik Maliyeti (TCO). Bu maliyet, milyon token başına dolar cinsinden ifade ediliyor. Basitçe belirtmek gerekirse, bir 'token', YZ tarafından üretilen verinin bir ölçüsü olarak kabul ediliyor. Temel performans ölçütü ise saniyede token (tok/s) olarak ifade ediliyor ve bu, bir GPU'ya veya kullanıcıya düşen miktara göre değişiklik gösterebiliyor.

YZ çıkarımında, daha fazla istemciyi aynı anda hizmet vermek, genellikle GPU kullanımını optimize ederek daha yüksek verim (throughput) elde edilmesini sağlıyor. Ancak, bu durum tek bir istemciye ayrılan süreyi azaltabiliyor. Bu da daha hızlı çıktı (örneğin, bir sohbet robotu konuşmasında) elde etmek için etkileşim (interactivity) seviyesini artırmayı ve dolayısıyla verimi düşürmeyi gerektiriyor. Bu durum, hızlı cevap veren ama bazen takılan sohbet robotları gibi örneklerle gözlemlenebiliyor.

Genel kullanıma yönelik bir sistemde, bu iki ölçüt arasında mükemmel bir denge kurulması gerekiyor. İdeal kurulumlar, verim ve etkileşim arasındaki ilişkiyi gösteren bir grafikte Pareto Cephesi Eğrisi üzerinde yer alıyor. GPU'lar, fiyatları ve güç tüketimleri göz önüne alındığında saatlik maliyet üzerinden alındığı için, herhangi bir senaryo için en iyi GPU her zaman en hızlı olanı olmayabiliyor; en verimli olanı tercih ediliyor.

InferenceMax, yüksek etkileşimli senaryoların, daha fazla kullanıcıya aynı anda hizmet verebildikleri için yüksek verimli senaryolardan daha pahalı olabileceğini, ancak potansiyel olarak daha karlı olabileceğini belirtiyor. Bu nedenle, hizmet sağlayıcıları için en önemli ölçüt, milyon token başına dolar cinsinden hesaplanan TCO oluyor. InferenceMax, GPU satın alma ve sahiplik ile kiralama gibi çeşitli senaryolar için bu rakamı tahmin etmeye çalışıyor.

Sadece bir GPU'nun performans grafiklerine ve ilişkili yazılım yığınına bakmak, tüm metrikler ve amaçlanan kullanım senaryosu dikkate alınmadığında en iyi seçeneğin ne olduğunu anlamak için yeterli değil. Ayrıca InferenceMax, yalnızca donanım değil, yazılım yığındaki değişikliklerin tüm metrikleri ve dolayısıyla TCO'yu nasıl etkileyeceğini de ortaya koyuyor.

Örnek olarak, InferenceMax, AMD'nin MI335X modelinin, Nvidia'nın daha hızlı olan B200'üne TCO açısından rekabetçi olabildiğini belirtiyor. Öte yandan, AMD'nin FP4 (4-bit kayan nokta formatı) çekirdeklerinin, bu matematiksel işlemlere dayanan senaryoların çoğunlukla Nvidia çiplerinin alanında olduğu göz önüne alındığında, iyileştirme için alan bıraktığı ifade ediliyor.

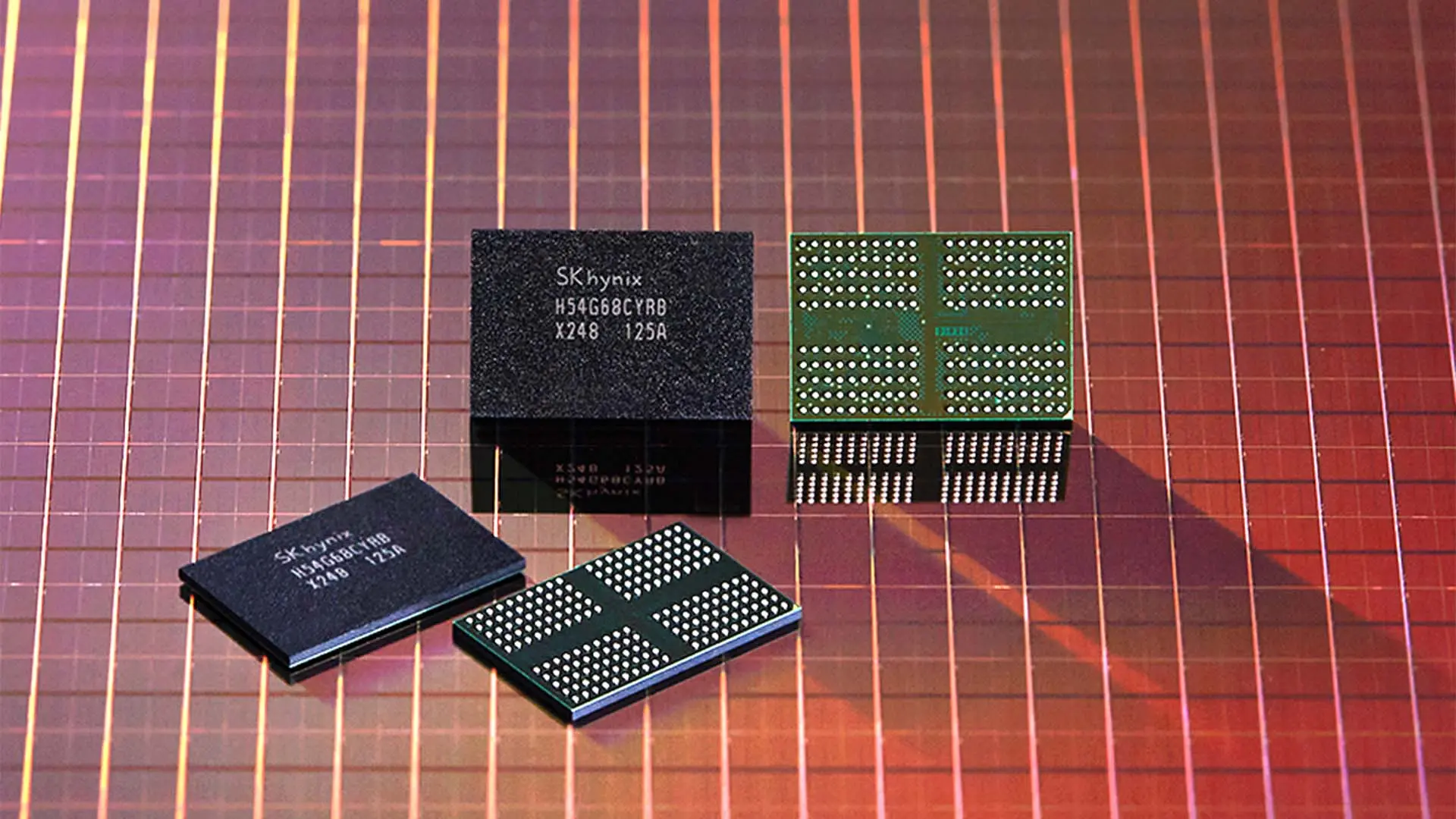

1.0 sürümüyle InferenceMax, Nvidia'nın GB200, NVL72, B200, H200 ve H100 hızlandırıcılarının yanı sıra AMD'nin Instinct MI355X, MI325X ve MI300X modellerini destekliyor. Proje, önümüzdeki aylarda Google'ın Tensor birimlerini ve AWS Trainium'u da desteklemeyi planlıyor. Benchmark'lar, GitHub Actions çalıştırıcıları aracılığıyla gece düzenli olarak çalıştırılıyor. Hem AMD hem de Nvidia'dan, GPU'lar ve yazılım yığınları için gerçek dünya konfigürasyon setleri talep edilmiş, çünkü bu ayarlar binlerce farklı şekilde optimize edilebiliyor.

Satıcı iş birlikleri konusunda, InferenceMax, birçok büyük satıcı ve bulut barındırma sağlayıcısından insanlara teşekkür ediyor; bazıları gece boyunca hataları düzeltti. Proje ayrıca hem Nvidia hem de AMD sistemlerinde birden fazla hata ortaya çıkararak, YZ hızlandırma sistemlerinin hızlı gelişim ve dağıtım temposunu vurguladı.

Bu iş birlikleri sonucunda AMD'nin ROCm'sinde (Nvidia'nın CUDA'sına eşdeğer) iyileştirmeler yapıldı. InferenceMax, AMD'nin kullanıcılara daha iyi varsayılan yapılandırmalar sunmaya odaklanması gerektiğini belirtiyor, çünkü optimal performansa ulaşmak için ayarlanması gereken çok fazla parametre olduğu bildiriliyor. Nvidia tarafında ise, yeni çıkan Blackwell sürücüleriyle bazı aksaklıklar yaşandı; özellikle örnekleri hızlı bir şekilde başlatıp sonlandıran benchmark senaryolarında başlatma/sonlandırma ile ilgili bazı sorunlar ortaya çıktı.

Bu alana ilgi duyanlar, InferenceMax'in duyurusunu ve ayrıntılı yazısını okuyabilir. Teknik zorlukların mizahi bir dille anlatıldığı keyifli bir okuma sunuyor.