OpenAI, Anthropic ve Google gibi şirketlerin geliştirdiği yapay zeka (YZ) kodlama asistanları, artık insan gözetimi altında saatlerce süren yazılım projelerinde çalışabiliyor. Bu asistanlar, tam teşekküllü uygulamalar yazabiliyor, testler çalıştırabiliyor ve hataları düzeltebiliyor. Ancak bu araçlar sihirli değnek değil ve bir yazılım projesini basitleştirmek yerine karmaşıklaştırabilir. Bu araçların çalışma prensibini anlamak, geliştiricilerin ne zaman (ve gerçekten) kullanmaları gerektiğini bilmelerine ve yaygın tuzaklardan kaçınmalarına yardımcı olacaktır.

Temelinde, her YZ kodlama asistanının merkezinde büyük dil modelleri (LLM'ler) adı verilen bir teknoloji bulunur. LLM'ler, büyük miktarda metin verisi, özellikle de bol miktarda programlama kodu üzerinde eğitilmiş bir sinir ağı türüdür. Bu modeller, bir komut (prompt) aracılığıyla eğitim sırasında gördüğü verilerin istatistiksel temsillerini çıkararak, bu örüntünün makul bir devamını çıktı olarak sunar. Bu çıkarım sırasında LLM'ler, alanlar ve kavramlar arasında enterpolasyon yapabilir; bu da iyi yapıldığında faydalı mantıksal çıkarımlara, kötü yapıldığında ise hatalı bilgilere yol açabilir.

Bu temel modeller, daha kullanışlı çıktılar üretmek, talimatları takip etmek ve araçları kullanmak üzere şekillendirilir. Bu amaçla, küratörlü örneklerle ince ayar (fine-tuning) ve insan geri bildiriminden pekiştirmeli öğrenme (RLHF) gibi tekniklerle daha da geliştirilirler.

Son birkaç yılda YZ araştırmacıları, LLM'lerin yetersizliklerini inceleyerek bunları aşmanın yollarını bulmaya çalıştılar. Yakın zamandaki yeniliklerden biri, LLM'nin daha doğru bir çıktıya ulaşmasına yardımcı olabilecek akıl yürütme tarzı metinler şeklinde bağlam oluşturan (prompt'u genişleten) simüle edilmiş akıl yürütme modelleri oldu. Başka bir yenilik ise, görevleri eş zamanlı olarak yerine getirmek ve çıktıları değerlendirmek için birden fazla LLM'yi birbirine bağlayan “asistan” adı verilen bir uygulamaydı.

Kodlama Asistanları Nasıl Yapılandırılır?

Bu anlamda, her YZ kodlama asistanı, birden fazla LLM ile çalışan bir programdır. Genellikle, insan kullanıcıdan gelen görevleri (prompt'ları) yorumlayan ve ardından bu görevleri, talimatları yürütmek için yazılım araçlarını kullanabilen paralel LLM'lere atayan bir “denetleyici” LLM bulunur. Denetleyici asistan, altındaki görevleri kesintiye uğratabilir ve bir projenin nasıl ilerlediğini görmek için alt görev sonuçlarını değerlendirebilir. Bu yapı, “bağlamı topla, eyleme geç, işi doğrula, tekrarla” şeklinde özetlenebilir.

Yerel bir komut satırı arayüzü (CLI) aracılığıyla çalıştırıldığında, kullanıcılara yerel makinede dosya yazma (kod veya gereken herhangi bir şey), keşif komutları çalıştırma (örneğin, bir dizindeki dosyaları listelemek için "ls"), web sitelerini getirme (genellikle "curl" kullanarak), yazılım indirme veya uzak sunuculara dosya yükleme gibi konularda koşullu izinler verilir. Bu yaklaşımla birçok olasılık (ve potansiyel tehlike) mevcuttur, bu nedenle dikkatli kullanılmalıdır.

Buna karşılık, bir kullanıcı web tabanlı bir asistanda bir görev başlattığında, sistem kullanıcının kod deposuyla önceden yüklenmiş, sanal alan (sandboxed) içine alınmış bir bulut kapsayıcısı sağlar. Bu kapsayıcıda, kod dosyalarını okuyabilir ve düzenleyebilir, komutları (test setleri ve kod analizi araçları dahil) çalıştırabilir ve kodu izole bir ortamda yürütebilir. Bu tür sistemler, daha özgürce çalışabileceği dosya sistemi ve ağ sınırları oluşturmak için işletim sistemi düzeyindeki özellikleri kullanır.

Bağlam Sorunu

Her LLM'nin, işini “unuttuğu” veriyi işlemeden önce sınırlı bir kısa süreli belleği vardır. Bu “bağlam” olarak adlandırılır. Denetleyici asistana her yanıt gönderdiğinizde, sohbetin o ana kadarki tüm geçmişini (üretilen tüm kod ve modelin problemi daha iyi "düşünmesi" için kullandığı simüle edilmiş akıl yürütme jetonları dahil) içeren devasa bir prompt'u güncellersiniz. Yapay zeka modeli daha sonra bu prompt'u değerlendirir ve bir çıktı üretir. Bu, LLM'ler prompt'taki her jetonu diğer tüm jetonlarla işlediği için, prompt boyutuna göre karesel olarak artan, hesaplama açısından çok maliyetli bir süreçtir.

Bağlam, azalan getirileri olan sınırlı bir kaynaktır. Yapılan çalışmalar, araştırmacıların “bağlam çürümesi” olarak adlandırdığı bir durumu ortaya koymuştur: Bağlam penceresindeki jeton sayısı arttıkça, modelin bilgiyi doğru bir şekilde hatırlama yeteneği azalır. Her yeni jeton, dokümantasyonda “dikkat bütçesi” olarak adlandırılan şeyi tüketir.

Bu bağlam sınırı, doğal olarak bir LLM'nin aynı anda işleyebileceği bir kod tabanının boyutunu sınırlar. Yapay zeka modeline çok büyük kod dosyaları yüklerseniz (ki her yanıt gönderdiğinizde LLM tarafından yeniden değerlendirilmesi gerekir), jeton veya kullanım limitlerini oldukça hızlı tüketebilir.

Ticaretin Püf Noktaları

Bu sınırlamaları aşmak için kodlama asistanlarının yaratıcıları çeşitli hileler kullanırlar. Örneğin, YZ modelleri, faaliyetleri diğer yazılım araçlarına devretmek için kod yazacak şekilde ince ayarlanır. Bütün dosyayı bir LLM'den geçirmek yerine, görüntü veya dosyalardan veri çıkarmak için Python betikleri yazabilirler. Bu, jeton tasarrufu sağlar ve hatalı sonuçlardan kaçınır.

Bazı sistemler, karmaşık veri analizlerini büyük veritabanları üzerinde gerçekleştirmek için de bu yaklaşımı kullanır. Hedefli sorgular yazılır ve büyük veri hacimlerini tam veri nesnelerini bağlama yüklemeden analiz etmek için “head” ve “tail” gibi komutlar kullanılır.

Bu YZ asistanları bir anlamda yönlendirilen ancak yarı özerk araç kullanan programlardır ve ilk kez 2023 başlarında gördüğümüz bir konseptin önemli bir uzantısıdır.

Asistanlarda bir başka önemli gelişme, dinamik bağlam yönetimi alanında geldi. Asistanlar, tescilli kodlama modellerinde tam olarak açıklanmayan birkaç yolla bunu yapabilir, ancak bildiğimiz en önemli teknik bağlam sıkıştırmadır.

Bir kodlama LLM'si bağlam sınırına yaklaştığında, bu teknik bağlam geçmişini özetleyerek sıkıştırır. Bu işlem sırasında detaylar kaybolur ancak geçmiş daha kısa anahtar detaylara indirgenir. Bu “sıkıştırma”, mimari kararlar ve çözülmemiş hatalar gibi anahtar detayları korurken, gereksiz araç çıktılarını atarak bağlam içeriğini yüksek doğrulukla damıtmak anlamına gelir.

Bu, YZ kodlama asistanlarının bu sıkıştırma her gerçekleştiğinde, yapmakta olduklarının büyük bir bölümünü periyodik olarak “unuttuğu” anlamına gelir. Ancak eski LLM tabanlı sistemlerin aksine, neler olup bittiği konusunda tamamen bilgisiz kalmazlar ve mevcut kodu, dosyalara bırakılan yazılı notları, değişiklik günlüklerini vb. okuyarak hızla yeniden yönlenebilirler.

Bazı yaklaşımlar, karmaşık görevler arasında asistan eylemlerini yönlendirmenin faydalı bir yoludur. Bu dosyalar, asistanların ilerlemelerini izlemelerini ve aksi takdirde kaybolacak kritik bağlamı korumalarını sağlar.

Karmaşık işler gerektiren görevler için, bazen “orkestratör-işçi” modeli kullanılır. Bu modelde, bir ana asistan süreci koordine ederken, paralel çalışan özel alt asistanlara görevler delege eder. Bir kullanıcı sorgusu gönderdiğinde, ana asistan bunu analiz eder, bir strateji geliştirir ve farklı yönleri eş zamanlı olarak keşfetmek için alt asistanlar oluşturur. Alt asistanlar akıllı filtreler gibi davranarak, tam bağlamlarını değil, yalnızca ilgili bilgileri ana asistana geri gönderir.

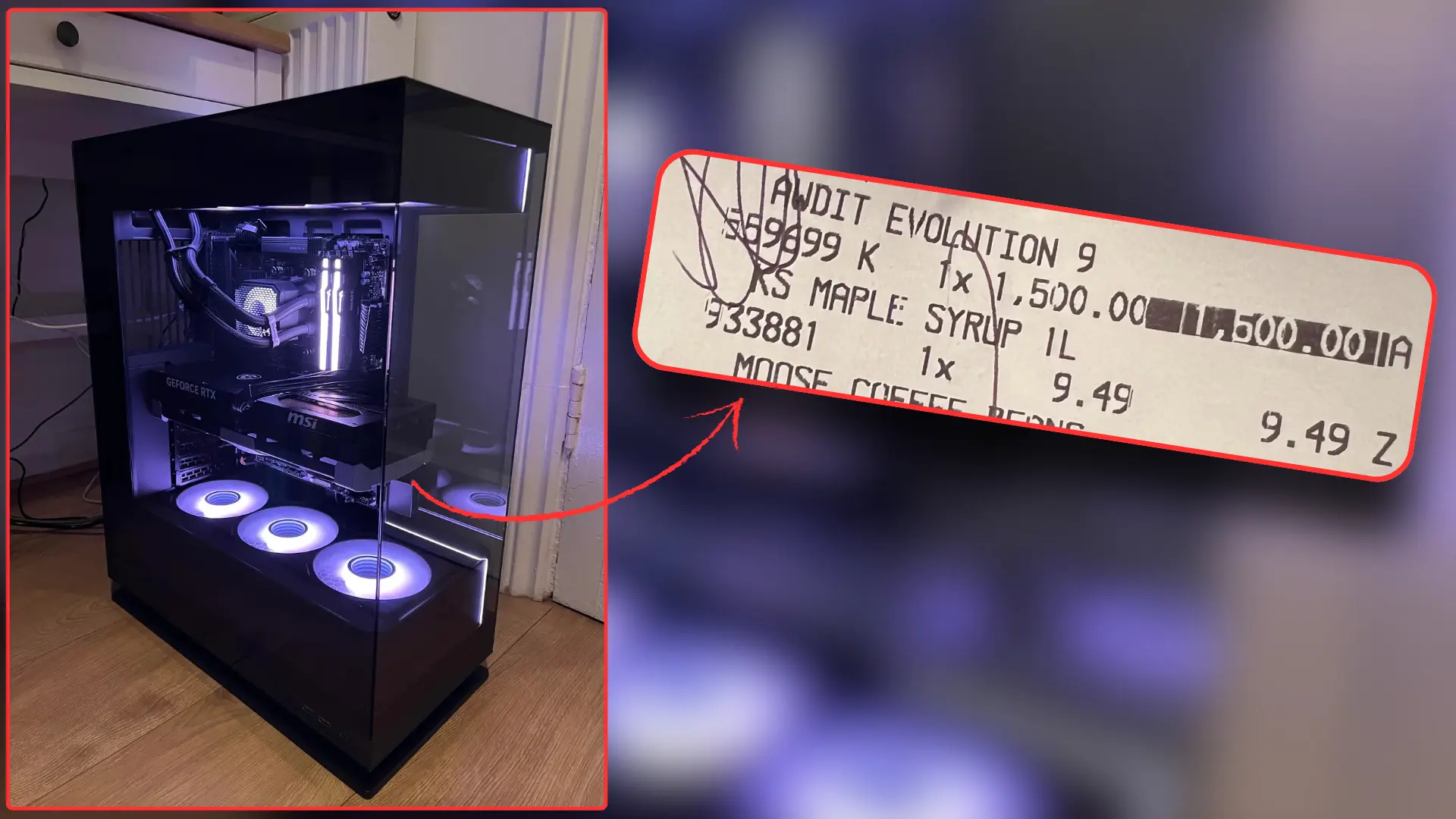

Bu çoklu asistan yaklaşımı hızla jeton tüketir. Asistanlar tipik olarak sohbet etkileşimlerinden yaklaşık dört kat daha fazla jeton kullanırken, çoklu asistan sistemleri sohbetlerden yaklaşık 15 kat daha fazla jeton kullanır. Ekonomik olarak sürdürülebilir olması için, bu sistemlerin, artan maliyeti haklı çıkaracak kadar yüksek değere sahip görevlere ihtiyaç duyması gerekir.

İnsanlar İçin En İyi Uygulamalar

Bu asistanları kullanmak bazı programlama çevrelerinde tartışmalı olsa da, bir projeyi kodlamak için bir tane kullanıyorsanız, iyi yazılım geliştirme uygulamalarını bilmek gelecekteki sorunları önlemeye yardımcı olur. Örneğin, sürüm kontrolü, artımlı yedeklemeler yapma, tek seferde bir özellik uygulama ve ilerlemeden önce test etme hakkında bilgi sahibi olmak faydalıdır.

“Vibe kodlama” olarak adlandırılan ve ne yaptığını anlamadan YZ tarafından üretilen kod oluşturma pratiği, üretim ortamı için açıkça tehlikelidir. Üretim ortamında kendinizin yazmadığı kodu göndermek, güvenlik sorunları veya başka hatalar getirebileceği veya zamanla büyüyebilecek teknik borç biriktirmeye başlayabileceği için risklidir.

Bağımsız YZ araştırmacıları, kodlama asistanlarını kullanan geliştiricilerin hala kodlarının çalıştığını kanıtlama sorumluluğunu taşıdığını savunuyor. LLM'den bin satırlık bir yama üreterek kod incelemesine göndermek artık değerli değil. Değerli olan, çalıştığı kanıtlanmış kod katkısı yapmaktır.

Aslında, insan planlaması anahtardır. Karmaşık problemler için belirli bir iş akışı önerilir: İlk olarak, asistandan ilgili dosyaları okumasını isteyin ve henüz kod yazmamasına açıkça belirtin, ardından bir plan yapmasını isteyin. Bu araştırma ve planlama adımları olmadan, çıktıların doğrudan bir çözümü kodlamaya eğilim gösterebileceği uyarısı yapılır.

Planlama olmadan, LLM'ler bazen anlık bir hedefi karşılamak için hızlı çözümlere başvurabilir ve bu, proje genişletilirse daha sonra sorun yaratabilir. Bu nedenle, zamanla genişletilebilen modüler bir program için iyi bir mimarinin ne anlama geldiğine dair bir fikre sahip olmak, LLM'yi daha dayanıklı bir şey oluşturmaya yönlendirmeye yardımcı olabilir.

Yukarıda belirtildiği gibi, bu asistanlar mükemmel değildir ve bazı insanlar onları hiç kullanmamayı tercih eder. Örneğin 2025 Temmuz'unda yayınlanan bir çalışmada, deneyimli açık kaynak geliştiricilerin YZ araçları kullanırken aslında %19 daha uzun sürdüğü, ancak daha hızlı çalıştıklarına inandıkları bulundu. Çalışmanın yazarları, geliştiricilerin kod tabanlarıyla son derece deneyimli olduklarını (ortalama beş yıl ve 1.500 taahhüt) ve kullanılan modellerin daha yetenekli sürümlerle değiştirilmiş olabileceğini belirtti.

Daha yeni modellerin farklı sonuçlar verip vermeyeceği sorusu açık olsa da, çalışma, YZ kodlama araçlarının, özellikle kod tabanlarını iyi bilen geliştiriciler için her zaman evrensel hızlanmalar sağlamayabileceğini düşündürmektedir.

Bu potansiyel tehlikeler göz önüne alındığında, şu anda kodlama asistanlarının ideal kullanımı muhtemelen kavram kanıtlama demoları ve dahili araçlardır. YZ modellerinin (asistan olarak adlandırılmalarına rağmen) gerçek bir ajansının olmadığı ve hatalardan sorumlu tutulabilecek insanlar olmadığı için, insan gözetimi kritiktir.