Yapay zeka teknolojileri baş döndürücü bir hızla gelişiyor. Bu alandaki en önemli bileşenler olan yapay zeka hızlandırıcılarının başını çeken AMD ve Nvidia, ürünlerini artık yıllık olarak piyasaya sürmeye başladı. Dahası, kendi silikonlarını üretebilecek güce sahip olan büyük bulut sağlayıcıları da bu trende uyum sağlayarak, Amazon Web Services, Google ve Meta'nın da 2020'lerin sonuna kadar her yıl yeni yapay zeka hızlandırıcıları sunması bekleniyor.

Peki, önümüzdeki yıllarda hangi işlemciler karşımıza çıkacak? Yapay zeka ve yüksek performanslı bilgi işlem (HPC) hızlandırıcı sektörü için önümüzdeki birkaç yıla dair büyük resmi çizdik. İşte detaylar:

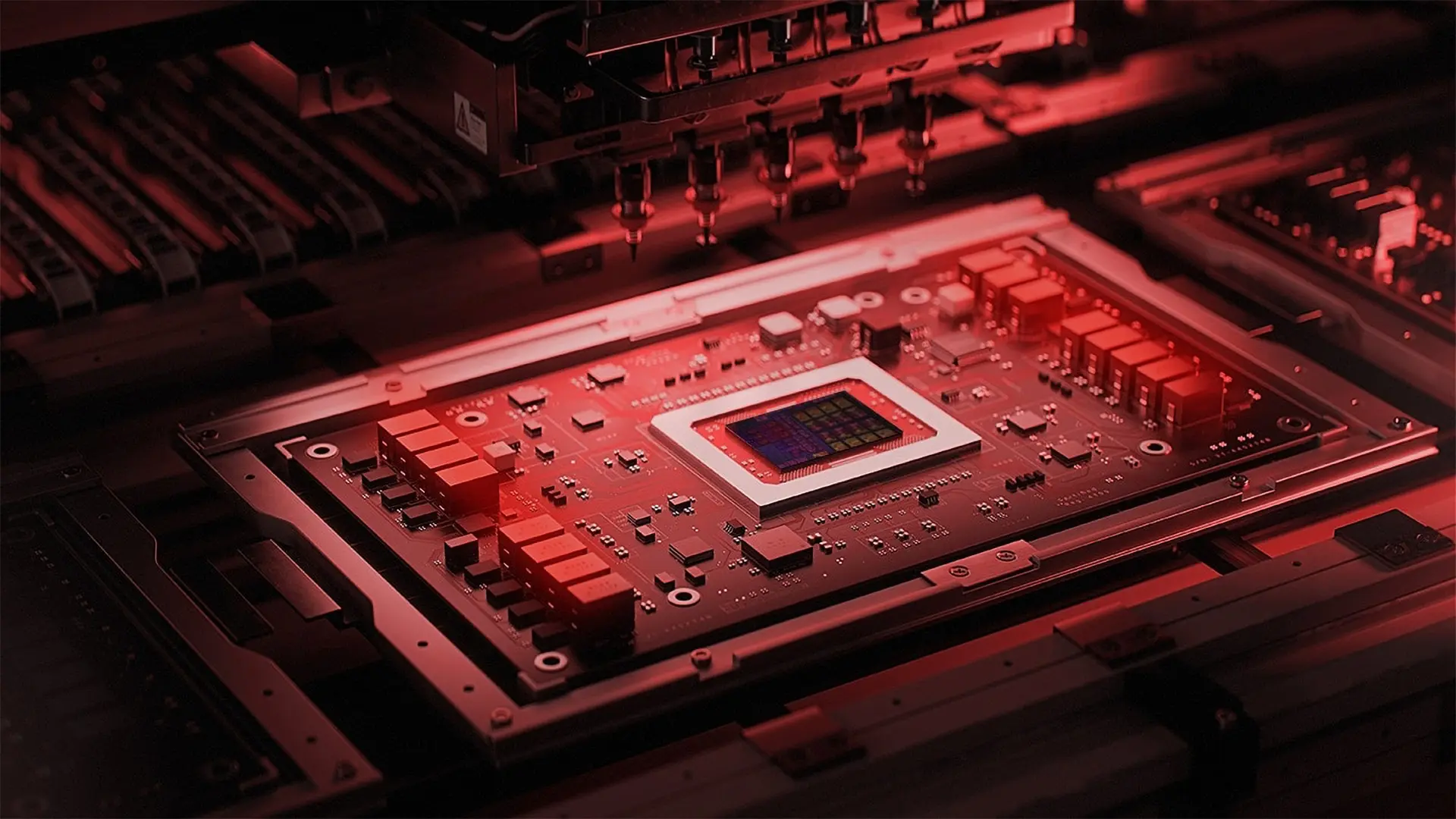

AMD'nin Gelecek Planları

Geleneksel olarak, 2020'lerin başındaki yüksek performanslı yapay zeka ve HPC hızlandırıcıları, AMD'nin Instinct MI100 ve MI200 serileri ile Nvidia'nın A100 ve H100 serileri gibi ürünler, temelde aynı ürüne karşılık geliyordu. Belki de bu nedenle birçok büyük bulut sağlayıcısı, maliyet, performans ve güç tüketimini optimize etmek için yapay zeka iş yüklerine özel kendi özel hızlandırıcılarını geliştirmeye karar verdi.

Nvidia'nın Blackwell ve Blackwell Ultra GPU'ları ağırlıklı olarak yapay zeka ile FP32 ve FP64 performansı için tasarlanmış olsa da, yeterli ve uygun özelliklerde FPÜ'ye sahip olmamaları nedeniyle HPC alanında rekabetçi değiller. AMD'nin en yeni Instinct MI350 serisi hala hem yapay zeka hem de HPC iş yüklerini hedefliyor. Neyse ki, AMD'nin yeni nesil işlemci GPU'ları yapay zeka çıkarımı (inference) için FP4 ve FP6 veri formatlarını destekliyor. Ancak GPU'nun FP64'ü de desteklemesi, şirketi düşük hassasiyetli iş yüklerinde bazı performans fedakarlıkları yapmaya zorladı.

Ancak AMD için işler, 2026'nın ikinci yarısında piyasaya çıkması beklenen Instinct MI400 serisi ile değişecek. Yeni MI450X, yapay zeka iş yüklerine odaklanırken, MI430X ise geleneksel süper bilgisayar uygulamalarını hedefleyecek. Her iki işlemcinin de TSMC'nin N2 (2nm sınıfı) üretim süreciyle üretilmesi, CoWoS-L teknolojisiyle paketlenmesi ve HBM4 bellekle donatılması bekleniyor.

Raporlara göre, her bir Instinct MI400 serisi işlemci, AMD'nin CDNA Next mimarisinin farklı alt kümeleri üzerine kurulacak. MI450X, FP4, FP8 ve BF16 gibi düşük hassasiyetli formatlara odaklanırken, MI430X ise FP32 ve FP64 gibi yüksek hassasiyetli formatları destekleyecek. Bu ayrımın, AMD'nin her çipten gereksiz işlem bloklarını ortadan kaldırarak silikon kullanımını daha verimli hale getirmesi ve belirli iş yükleri için daha iyi ayar yapması bekleniyor.

Her iki hızlandırıcı da Infinity Fabric ve UALink bağlantısını içerecek. Bunlar UALink'i entegre eden ilk GPU'lardan bazıları olsa da, Astera Labs, Auradine, Enfabrica ve XConn gibi harici ortakların 2026'nın ikinci yarısına kadar anahtarlama donanımlarının hazır olması beklenmediği için lansmandaki benimsenmesi sınırlı kalacaktır. Bu anahtarlar olmadan, UALink kullanan büyük ölçekli dağıtımlar 2026'da mümkün olmayacak, sistemleri mesh ve torus gibi küçük ölçekli topolojilere kısıtlayacaktır. Yine de AMD, mevcut ağ kartları tarafından zaten desteklenen Ultra Ethernet teknolojisini kullanarak ölçeklenecek olan 72 GPU'lu Helios raf ölçeği çözümünü sunmaya devam edecek.

AMD'nin Instinct MI400 serisini, 2027 yılında piyasaya çıkması beklenen Instinct MI500 serisi GPU'lar takip edecek. Bu nedenle MI500 işlemcilerin TSMC'nin N2 üretim düğümünde üretilmesi ve CoWoS-L ile paketlenmesi bekleniyor, ancak AMD'nin bu birimler için HBM4E'yi benimseyip benimsemeyeceği henüz belli değil. Instinct MI500 serisi işlemciler, 256 GPU taşıyacak olan AMD'nin yeni nesil yapay zeka raf ölçeği çözümüne güç verecek.

Amazon'un Özel Hızlandırıcıları

Amazon, yapay zeka hızlandırıcılarını yalnızca kendi veri merkezlerinde kullanıyor, bu nedenle şirketin iki çipi hakkında çok fazla detay açıklanmıyor. Amazon, hem eğitim (training) hem de çıkarım (inference) için Trainium çiplerini, yalnızca çıkarım iş yükleri için ise Inferentia çiplerini kullanıyor.

Amazon, en az iki nesil Trainium ve Inferentia işlemcisini başarıyla dağıtmış durumda, bunlar arasında en yeni Trainium2 Ultra (667 BF16 TFLOPS, 1300 FP8 TFLOPS, 96 GB HBM3E, CoWoS-R) bulunuyor. İlginç bir şekilde, Amazon'un önümüzdeki yıllarda daha fazla Inferentia işlemcisi üretme planı yok gibi görünüyor, çünkü odağını Trainium'a çevirmeyi amaçlıyor. Ancak bu değişiklik şirket tarafından resmi olarak doğrulanmadı ve hala bir söylenti olarak kalıyor.

Amazon'un 2025 sonu – 2026 başı için planları arasında, daha yüksek performans, yeni veri formatları desteği ve 128 GB'a kadar HBM3E bellek sunması beklenen Trainium3 yer alıyor. Çipin TSMC'nin 3nm sınıfı düğümlerinden birinde, büyük olasılıkla N3P'de üretilmesi bekleniyor. Trainium3 çipini, 2026-2027'de 128 GB HBM4'e sahip olacak ve performansı daha da artıracak olan Trainium3 Ultra takip edecek. Bundan sonra, Amazon'un 2027-2028'de 2nm tabanlı bir Trainium4 çipi piyasaya sürmesi bekleniyor, ancak şu anda tahmini performans veya özellikler hakkında detay bulunmuyor.

Google'ın TPU Yol Haritası

Google, 2015'ten beri yapay zeka hızlandırıcılarını geliştiriyor, performansını titizlikle artırıyor ve performanslı (örneğin, TPU v5p) ve verimli (örneğin, TPU v5e) tensör işleme birimlerine (TPU) özellikler ekliyor.

Geçen yıl şirket, ağırlıklı olarak düşük güçlü çıkarım iş yükleri için tasarlanmış 32 GB HBM3 ile donatılmış Trillium (TPU v6e) çipini tanıttı. Bu yıl şirket, büyük ölçekli eğitim ve çıkarım iş yükleri için tasarlanmış 7. Nesil TPU'su olan Ironwood hızlandırıcısını tanıttı. Her çip, TSMC'nin 3nm sınıfı işlem teknolojisi üzerinde üretiliyor, 4.614 FP8 TFLOPS performans sunuyor (öncülü TPU v5p'den 10 kat daha fazla, ancak Nvidia'nın H100'ünden sadece biraz daha yüksek) ve 192 GB HBM3E ile geliyor.

Birim, 7.37 TB/s HBM bant genişliği, v5p'nin yaklaşık 2,64 katı ve 1.2 TB/s çift yönlü Çip İçi Bağlantı (ICI) bant genişliği sunuyor. Ironwood pod'ları 9.216 çipe kadar ölçeklenebiliyor ve toplam 42.5 FP8 ExaFLOPS sağlıyor, bu da onu bugüne kadar üretilmiş en güçlü sistemlerden biri yapıyor. Verimlilik açısından Ironwood, Trillium'a göre watt başına yaklaşık iki kat daha iyi performans sunuyor ve Google'ın ilk Cloud TPU'sundan neredeyse 30 kat daha fazla güç verimli.

Ironwood (TPU v7p)'den sonra Google'ın 8. Nesil TPU'ları olan v8p ve v8e'yi piyasaya sürmesi bekleniyor. Bu TPU'ların TSMC'nin 3nm sınıfı işlem teknolojisi üzerinde üretileceği ve 288 GB'a kadar HBM3E bellek içereceği söyleniyor. Bu nedenle bu parçalardan büyük bir performans artışı beklenmemeli. Google'ın v8p ve v8e hızlandırıcıları 2026 yılı için planlanıyor.

Google'ın TPU'ları, şirket 9. Nesil TPU'sunu yeni bir mimari ve HBM4 bellek ile piyasaya süreceği 2027 veya 2028'de muhtemelen büyük bir performans artışı görecek. Bu parçaların TSMC'nin N2 üretim sürecini kullanarak oluşturulması ve CoWoS-L paketlemesini kullanması bekleniyor, bu da sistem içi paketler için çok yüksek dahili bant genişliği anlamına geliyor. Bazıları TSMC ve Google'ın hibrit bağlama teknolojisini benimseyebileceğine inanıyor, ancak bu henüz belli değil.

Intel'in AI Alanındaki Yeri

Intel'in CPU'ları yapay zeka sunucularında yaygın olarak kullanılsa da, Gaudi 3 hızlandırıcılarının şu ana kadar pek ilgi görmediği görülüyor. Birden fazla sadık ortak Gaudi 3 tabanlı sunucular sunarken ve Dell bir Gaudi 3 kartlı iş istasyonu sunarken, şirketin yapay zeka hızlandırıcı pazarındaki payı ihmal edilebilir düzeyde.

Büyük şirketlerin Gaudi için yapay zeka modellerini geliştirmekte veya dağıtmada tereddüt etmelerinin bir nedeni, Intel'in Gaudi'nin 2026-2027'de yapay zeka GPU'larını piyasaya sürdüğünde durdurulacağını zaten duyurmuş olmasıdır. Birkaç yıl içinde nesli tükenecek bir platforma on milyonlarca dolar yatırım yapmak, büyük oyuncuların yapacağı bir şey değil, bu yüzden Gaudi'nin popülerlik kazanması pek olası değil. Hatta Gaudi 3 işlemcisi için bir güncelleme yayınlayıp yayınlamayacağı bile belirsizliğini koruyor.

Intel'in GPU planlarına gelince, firma kod adı Falcon Shores GPU'yu kendi iç geliştirme amaçları için kullanacak ve seçkin yapay zeka şirketlerine erişim sağlayabilir. Yapay zeka iş yükleri için Intel'in ilk işlemci GPU'su olan kod adı Jaguar Shores, çok çeşitli müşteriler tarafından kullanılabilir olacak ve 2027'de piyasaya sürülmesi planlanıyor.

Meta'nın Kendi Çip Girişimleri

Meta, yapay zeka alanındaki donanım yatırımı konusunda liderlerden biri olmasına rağmen, şirket içi yapay zeka silikon çabaları rakiplerinin gerisinde kalıyor. Meta'nın kendi yapay zeka çiplerine Meta Eğitim ve Çıkarım Hızlandırıcıları (MTIA) adı veriliyor. Andes ile RISC-V tabanlı işlem öğeleri (PE'ler) ve Broadcom ile doğrusal dizi mimarisi kullanan işlemciler tasarlayan bir işbirliği ile geliştiriliyorlar.

Meta'nın 1. Nesil MTIA v1'i 2023'te tanıtıldı: TSMC'nin 7nm sınıfı işlem teknolojisi üzerinde üretilmiş bir çip kullandı ve 64 GB LPDDR5 bellek ile donatılmıştı. Meta'nın kendisi MTIA v1'in veri merkezlerinde dağıtıldığını ve öneri ve sıralama modellerini üretimde kullandığını belirtti.

Ancak, bu dağıtım dahili iş yükleriyle sınırlı görünüyor ve tam bir altyapı değişimi için beklenecek ölçekte olmayabilir. Şirketin daha yeni MTIA çipleri TSMC'nin 5nm sınıfı üretim sürecinde üretiliyor ve yerleşik belleği 128 GB (MTIA 2) ve 256 GB (MTIA 2.5) olarak ikiye katlıyor. Ancak şirket, MTIA'nın sonraki nesilleriyle daha agresif olacak.

Meta'nın MTIA v3'ü (2026'da gelmesi bekleniyor), TSMC'nin N3 üretim süreci üzerinde üretilen bir işlem yongası kullanması ve HBM3E bellek kullanması beklendiği için önemli ölçüde daha yüksek performanslı bir çözüm olması öngörülüyor. Şirketin ayrıca 2027'de MTIA v4'ü piyasaya sürmesi bekleniyor. Bu hızlandırıcı muhtemelen TSMC'nin 2nm üretim sürecinde üretilmiş iki veya daha fazla yonga ve HBM4 bellek ile donatılacak.

Microsoft'un Özel Çip Girişimleri

Microsoft, Amazon, Google ve Meta'dan yıllar sonra 2023'ün sonlarında piyasaya sürdüğü Maia 100 serisi ile özel yapay zeka silikonuna geçişte biraz geç kaldı. Maia 100, TSMC tarafından 5nm sınıfı bir üretim düğümü üzerinde üretiliyor, 105 milyar transistör içeriyor ve 64 GB HBM2E bellek ile donatılmış.

Microsoft'un kendi bloguna göre, Maia 100, büyük ölçekli yapay zeka eğitim ve çıkarım iş yüklerini desteklemek üzere Azure'a dağıtıldı. Ancak dış raporlar, Maia'nın dağıtımının Microsoft'un tüm hizmet altyapısında yaygın olmadığını ve Azure yapay zeka hizmetlerinin büyük çoğunluğunun hala AMD ve Nvidia'dan GPU'lar gibi iş ortağı donanımlarına dayandığını gösteriyor.

Şirket şu anda yeni nesil Maia işlemcileri üzerinde çalışıyor: kod adı Braga (Maia 200?) çipi TSMC'nin 3nm düğümünü ve HBM4 belleği kullanacak. Braga'nın 2026'da piyasaya çıkması, ardından Clea (Maia 300?)'nın daha sonra gelmesi bekleniyor. Ancak Maia'nın sınırlı benimsenmesi göz önüne alındığında, Microsoft kendi yapay zeka hızlandırıcılarının konumlandırmasını karmaşıklığı ve riski azaltmak için yeniden ayarlamak isteyebilir.

Nvidia'nın Pazardaki Hakimiyeti ve Geleceği

Broadcom ve Marvell gibi birçok şirket yapay zeka iş yükleri için XPU'lar geliştirirken, Nvidia hem eğitim hem de çıkarım iş yükleri için pazar lideri olmaya devam ediyor. Şirketin en yeni Blackwell Ultra mimarisi, ağırlıklı olarak çıkarım için kullanılan NVFP4 performansı lehine INT8, FP32 ve FP64 performansından ödün veriyor. Dolayısıyla Nvidia, yapay zeka endüstrisindeki baskın gücü olarak tacını korumak için her şeyi yapıyor.

Nvidia'nın önümüzdeki veri merkezi GPU'sunun kod adı Rubin ve 2026'nın sonlarında piyasaya çıkması bekleniyor. İlk model, geçici olarak R100/R200 olarak adlandırılacak ve TSMC'nin 3nm sınıfı düğümü (muhtemelen N3P veya Nvidia'nın ihtiyaçları için özelleştirilmiş bir şey) üzerinde üretilmiş iki retikül boyutunda GPU çipi ve iki adet özel G/Ç çipletinden oluşacak. Bellek açısından, her biri 6.4 GT/s hızında çalışan sekiz yığın üzerinden 288 GB HBM4 entegre edecek ve etkileyici yaklaşık 13 TB/s toplam bellek bant genişliği sağlayacak.

R100/R200, öncelikli olarak yapay zeka hızlandırması için tasarlanmıştır; çıkarım için 50 PFLOPS NVFP4 performansı ve eğitim iş yükleri için yaklaşık 17 FP8 TFLOPS'a ulaşması bekleniyor. Diğer formatlar için performans verileri henüz paylaşılmadı, ancak Blackwell nesline kıyasla genel olarak artışlar bekleniyor. Bu performans artışı bir bedelle gelecek: her VR200 biriminin 1.800 watt güç çekeceği öngörülüyor, bu da veri merkezi altyapısı için yeni güç ve soğutma talepleri yaratıyor.

Ancak yapay zeka için Nvidia'nın Rubin GPU'ları yalnız gelmeyecek. Nvidia ayrıca, uzun bağlamlı çıkarımın bağlam aşamasını işlemek üzere tasarlanmış yeni tanıtılan bir GPU olan Rubin CPX'i de sunacak. Bu iş yükü, çıktı üretmeden önce 1 milyon tokene kadar işleme yapması gereken yeni nesil yapay zeka modellerinde giderek yaygınlaşıyor.

Rubin R100/R200 gibi yüksek güçlü, yüksek bant genişlikli GPU'lara (HBM4 kullanan) tek başına güvenmek yerine, CPX bu özel görevi, 128 GB GDDR7 içeren, HBM'ye daha ucuz, daha serin ve daha basit bir bellek alternatifi sunan işlemci yoğun (ancak bant genişliği düşük) bir CPX GPU'ya devrediyor. 30 petaFLOPS NVFP4 işlem performansı, dikkat mekanizmaları için donanım hızlandırması ve hatta video kodlama/kod çözme desteği ile CPX, nispeten düşük maliyet ve güç tüketimiyle hızlı girdi işleme için özel olarak tasarlanmıştır. Nvidia'nın Rubin CPX GPU'su, raf başına 8 exaFLOPS NVFP4 işlem gücü ve 100 TB bellek sunacak olan NVL144 CPX sisteminde Rubin ve Vera CPU'larla birlikte çalışacak.

2027'de Nvidia, önemli ölçüde yükseltilmiş bir varyant olan Rubin Ultra (VR300)'yı piyasaya sürmeyi planlıyor. Bu, iki adet G/Ç çipiyle birlikte dört retikül boyutunda GPU karosunu içerecek ve 16 yığından oluşan 1 TB HBM4E belleği destekleyecek, bu da 32 TB/s'lik muazzam bir bant genişliği sağlayacak. Hedeflenen FP4 performansı 100 PFLOPS olacak, bu da onu çıkarım için VR200'den iki kat daha hızlı hale getirecek.

Ancak VR300'ün ölçeği muazzam bir güç gerektiriyor - paket başına 3.600 watt -, bu da onu yalnızca gelişmiş sıvı soğutma sistemlerine sahip son derece özel, yüksek yoğunluklu dağıtımlar için uygun hale getiriyor. Nvidia, hem VR200 hem de VR300 için CoWoS-L paketlemesini kullanmaya devam edecek, ancak Rubin Ultra varyantının ayak izi, TSMC'nin gelecekteki 9.5 retikül CoWoS-L ara katmanını (120 x 150 mm boyutunda) veya dikişli daha küçük ara katmanların bir düzenini gerektirecek, çünkü resmi slaytlarda herhangi bir dikey yonga istifleme görünmüyor.

Rubin'in ötesine bakıldığında, Nvidia'nın 2028 planları, kod adı Feynman olan bir sonraki GPU ailesini içeriyor. Özel mimari ayrıntıları mevcut olmasa da, bu işlemcilerin muhtemelen TSMC'nin A16 işlem teknolojisi üzerinde arkadan güç dağıtımı (hem transistör yoğunluğu hem de performans için nihai bir artış sağlayacak) ile üretileceği ve yeni nesil HBM'yi benimseyeceği belirtiliyor. Bunun, özel bir HBM4E formu mu yoksa erken HBM5 mi olduğu hala belirsiz - ancak ikincisi bu zaman dilimi için erken görünüyor.

OpenAI'nin Gizemli Hızlandırıcı Projesi

OpenAI, belki de ChatGPT hizmetinin popülerliği nedeniyle en çok bilinen yapay zeka şirketi, ancak yapay zeka donanımı açısından yeni bir oyuncu. Şirketin, muhtemelen Broadcom ile birlikte en azından 2023'ün sonlarından beri kendi yapay zeka hızlandırıcısı üzerinde çalıştığı bildiriliyor.

Son zamanlarda Broadcom, açıklanmayan bir müşterinin, 2026'nın üçüncü çeyreğinde teslim edilecek 10 milyar dolarlık özel yapay zeka işlemcisi siparişi verme niyetinde olduğunu doğruladı. Endüstri, söz konusu ürünün OpenAI'nin ilk özel yapay zeka işlemcisi olduğuna inanırken, bu hiçbir zaman resmi olarak doğrulanmadı.

OpenAI'nin iddiaya göre ihtiyacına göre üretilen özel işlemcileri tedarik etmek için 10 milyar dolar harcayacak olması, birim fiyatlara bağlı olarak 1-2 milyon XPU'ya işaret edebilir. Ancak, Nvidia ile olan son anlaşması, muhtemelen birden fazla GPU nesli boyunca 100 milyar dolarlık Nvidia GPU donanımına erişim sağlayacağını gösteriyor. Bu, OpenAI'nin iş yüklerinin büyük çoğunluğunun hala Nvidia'ya dayanacağı ve modellerinin CUDA platformu için optimize edileceği anlamına geliyor.