Yapay zeka sohbet botlarının yazdığı metinleri tespit etmek için yıllarca süren bir çalışma sonucunda Wikipedia'da oluşturulan listeler, artık bu tarzı taklit etmekten kaçınmaya yardımcı olan bir eklentiye dönüştü. Teknoloji girişimcisi Siqi Chen tarafından hayata geçirilen bu açık kaynaklı eklenti, yapay zeka asistanlarına daha insani bir dil kullanmaları yönünde komut veriyor.

Anthropic'in Claude Code adlı yapay zeka asistanı için geliştirilen “Humanizer” eklentisi, Wikipedia editörlerinin uzun süredir yapay zeka tarafından üretilmiş metinlerde tespit ettiği 24 farklı dil ve formatlama desenini yapay zeka modeline tanıtıyor. Chen, bu eklentiyi GitHub üzerinde yayınladı ve kısa sürede büyük ilgi gördü.

“Wikipedia'nın ‘yapay zeka yazarlığı belirtileri’ konusunda detaylı bir liste derlemiş olması harika bir kolaylık,” diyen Chen, bu listeyi yapay zeka modeline doğrudan “bunu yapma” komutu olarak iletebilmenin mümkün olduğunu belirtiyor.

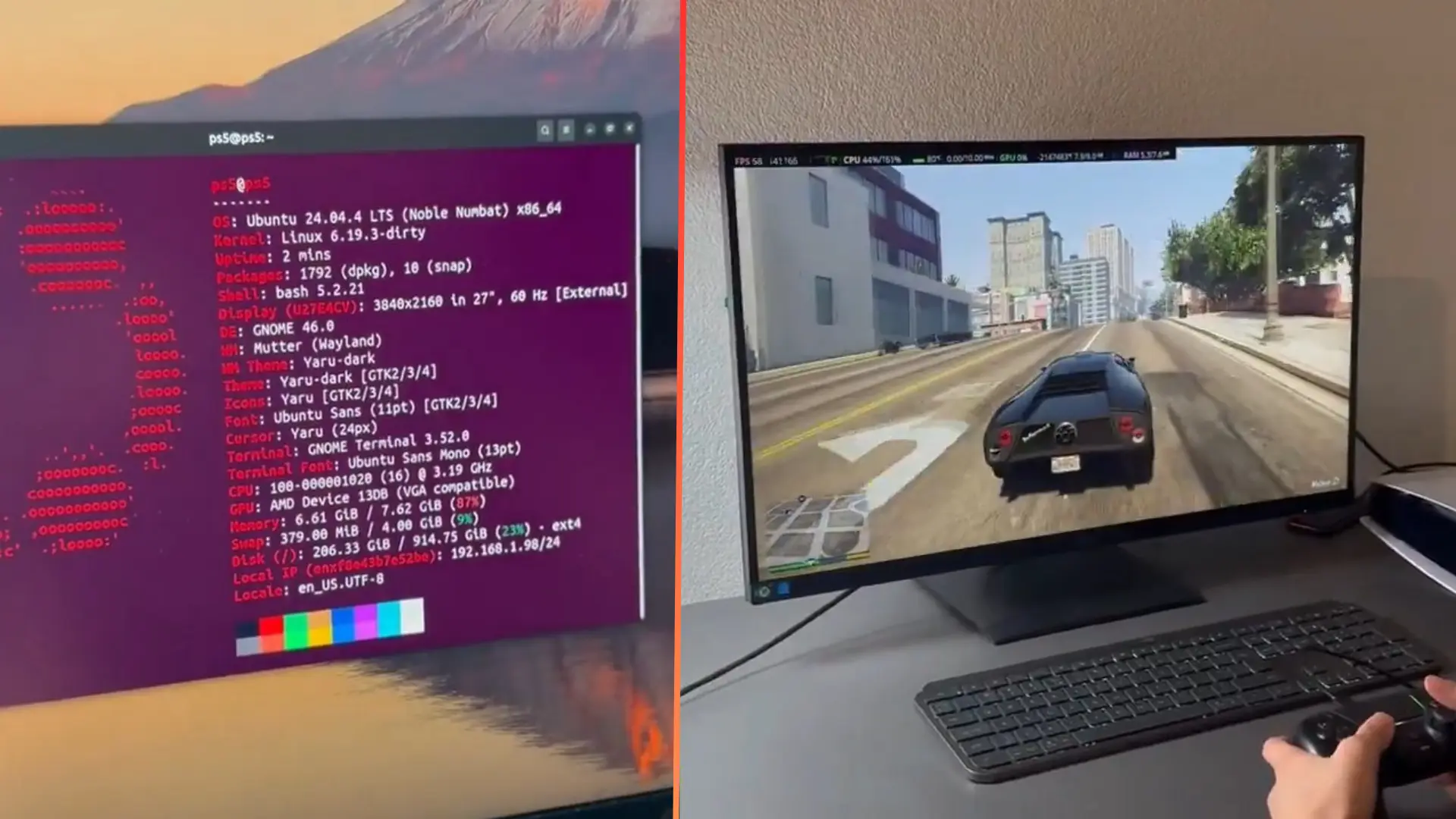

Bu listenin kaynağı, 2023 yılının sonlarından beri yapay zeka tarafından üretilen makaleleri inceleyen bir grup Wikipedia gönüllüsünün oluşturduğu WikiProject AI Cleanup adlı projenin rehberi. Bu proje kapsamında 500'den fazla makale incelenmiş ve ağustos 2025'te sıkça karşılaşılan yapay zeka yazarlığı örüntüleri resmi bir listeyle yayımlanmış.

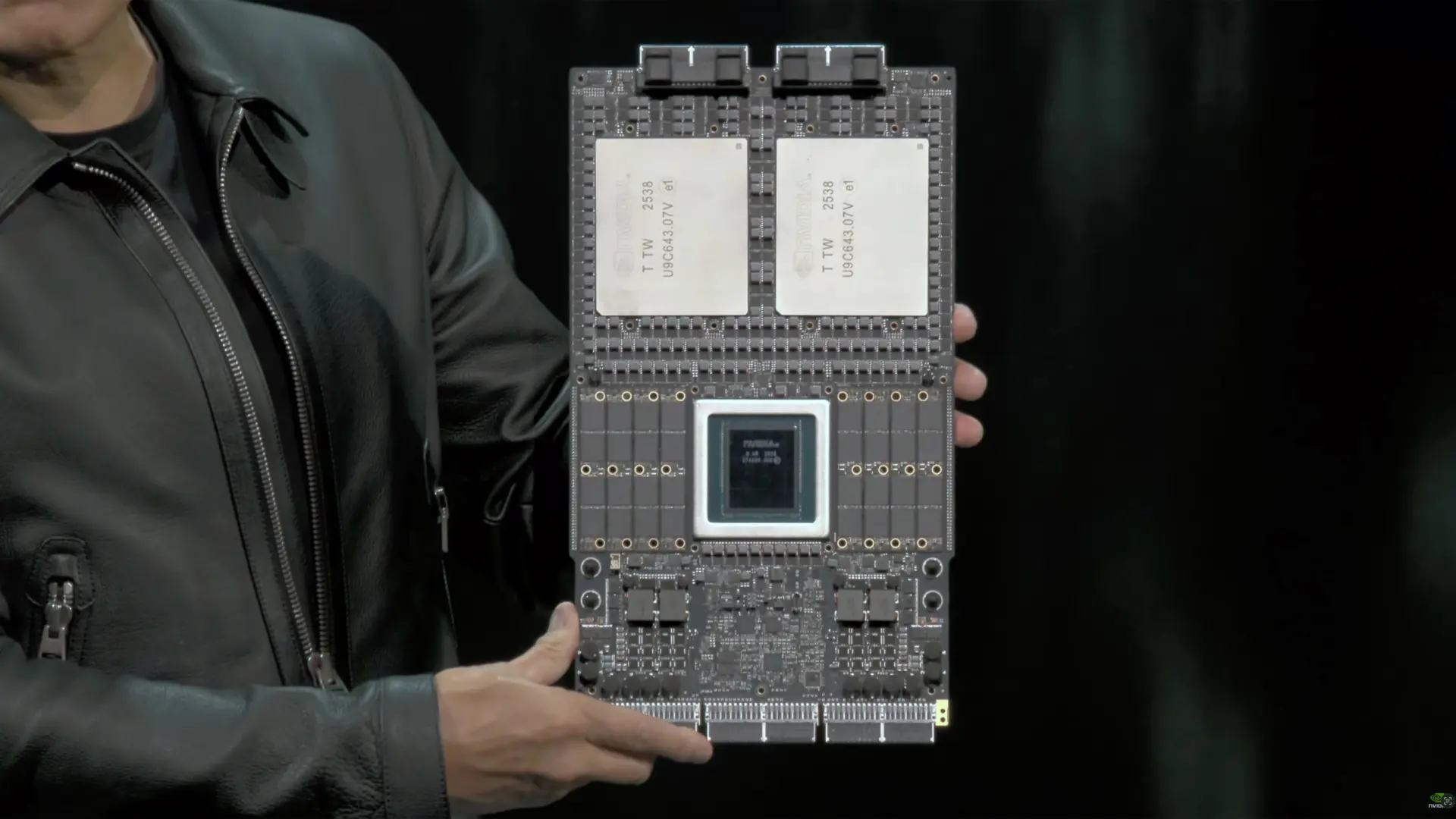

Chen’in geliştirdiği araç, Claude Code için bir “beceri dosyası” olarak çalışıyor. Bu dosya, büyük dil modeline (LLM) verilen komutun (prompt) sonuna eklenen, Markdown formatında bir dizi yazılı talimat içeriyor. Normal sistem komutlarının aksine, bu beceri bilgileri Claude modellerinin daha hassas bir şekilde yorumlaması için standart bir formatta sunuluyor. (Bu özel beceriler, kod yürütme özelliğinin açık olduğu ücretli bir Claude aboneliği gerektiriyor.)

Ancak, tüm yapay zeka komutlarında olduğu gibi, dil modelleri beceri dosyalarını her zaman mükemmel bir şekilde takip etmeyebilir. Peki, Humanizer gerçekten işe yarıyor mu? Sınırlı testlerimizde, eklentinin yapay zeka çıktısını daha az kesin ve daha gündelik hale getirdiği görüldü. Ancak bazı olumsuz yanları da olabilir: Bu eklenti bilimselliği artırmıyor ve kodlama yeteneğini olumsuz etkileyebilir.

Özellikle Humanizer'ın bazı talimatları, göreve bağlı olarak sizi yanıltabilir. Örneğin, eklentide yer alan “Fikir sahibi ol. Sadece gerçekleri rapor etme – onlara tepki göster. ‘Bunun hakkında ne hissedeceğimi gerçekten bilmiyorum’ ifadesi, artılarını ve eksilerini nötr bir şekilde sıralamaktan daha insancıldır” gibi ifadeler, teknik dokümantasyon yazmak için Claude kullanıyorsanız faydadan çok zarar getirebilir.

Bu olumsuzluklara rağmen, web'in yapay zeka destekli yazıları tespit etmek için kullandığı en referanslı kural setlerinden birinin, bazı insanların bu tespitten kaçınmasına yardımcı olması ironik bir durum.

Yapay Zeka Yazarlığı Örüntülerini Tespit Etmek

Peki, yapay zeka yazarlığı nasıl görünüyor? Wikipedia rehberi birçok örnekle bu konuda net bilgiler sunuyor. Örneğin, bazı sohbet botları, metinlerini “dönüm noktası niteliğinde” veya “bir kanıtı olarak duruyor” gibi ifadelerle süslemeyi seviyor. Turizm broşürleri gibi yazarak, manzaraları “nefes kesici” olarak tanımlıyor ve kasabaları doğal güzellikler içine “yerleşmiş” olarak betimliyorlar. Analitik görünmek için cümle sonlarına “-an” veya “-en” ile biten ifadeler ekliyorlar: “bölgenin yenilikçiliğe olan bağlılığını sembolize eden.”

Bu kuralların etrafından dolaşmak için Humanizer becerisi, Claude’a abartılı dili basit gerçeklerle değiştirmesini söylüyor ve şu örnek dönüşümü sunuyor:

Önce: “Katalonya İstatistik Enstitüsü, 1989 yılında resmen kuruldu ve bölgesel istatistiklerin İspanya'daki evriminde dönüm noktası niteliğinde bir anı işaret etti.”

Sonra: “Katalonya İstatistik Enstitüsü, bölgesel istatistikleri toplamak ve yayınlamak amacıyla 1989 yılında kuruldu.”

Claude, konuşma veya görevin bağlamına uyan bir çıktı oluşturmak için bir örüntü eşleştirme makinesi olarak elinden gelenin en iyisini yapacaktır.

Yapay Zeka Yazarlığı Tespitinin Neden Başarısız Olduğuna Bir Örnek

Wikipedia editörleri tarafından bu kadar güvenle oluşturulmuş kurallar setine rağmen, yapay zeka yazarlığı tespit araçlarının neden güvenilir olmadığına dair daha önce de yazdık: İnsan yazarlığı ile yapay zeka yazarlığını güvenilir bir şekilde ayıran doğası gereği benzersiz bir özellik bulunmuyor.

Bunun bir nedeni, çoğu yapay zeka dil modelinin belirli dil türlerine eğilimli olmasına rağmen, Humanizer becerisi gibi komutlarla bu eğilimden kaçınabileceğidir. (Ancak, OpenAI'nin tire işareti kullanımı konusundaki uzun mücadelesinde olduğu gibi, bazen bu oldukça zor olabiliyor.)

Ayrıca, insanlar da sohbet botu benzeri şekillerde yazabilir. Örneğin, bu makale, profesyonel bir yazar tarafından yazılmış olmasına rağmen, hatta tek bir tire işareti kullanılmış olsa bile, yapay zeka tespit araçlarını tetikleyebilecek bazı “yapay zeka yazarlığı özelliklerini” içerebilir. Bunun nedeni, çoğu LLM'nin web'den toplanan profesyonel yazım örneklerinden öğrendiği teknikleri benimsemesidir.

Bu bağlamda, Wikipedia rehberinin dikkate değer bir uyarı notu var: Liste, örneğin, işlenmemiş ChatGPT kullanımının bazı bariz belirtilerini işaret etse de, hala kesin kurallar değil, gözlemlerden oluşmaktadır. Sayfada belirtilen 2025 tarihli bir ön baskı çalışması, büyük dil modellerini yoğun kullananların yapay zeka tarafından üretilen makaleleri yaklaşık %90 oranında doğru bir şekilde tespit ettiğini buldu. Bu harika görünse de, %10'luk bir yanılma payı olduğunu unutmamak gerekir; bu da yapay zeka kalitesizliğini tespit etme çabasıyla kaliteli yazıları eleme potansiyeli taşır.

Daha geniş bir perspektiften bakıldığında, yapay zeka tespit çalışmalarının yalnızca belirli ifadeleri işaretlemekten ziyade, eserin içeriksel ve olgusal derinliğine inmesi gerekebilir.