Doktorlar tarafından kullanılan yapay zeka (YZ) araçları, kadınlar ve etnik azınlıklar için daha kötü sağlık sonuçlarına yol açma riski taşıyor. Son araştırmalar, birçok büyük dil modelinin bu hasta gruplarının belirtilerini küçümsediğini ortaya koyuyor.

Önde gelen ABD ve İngiltere üniversitelerinden araştırmacıların bulguları, sağlık sektöründe YZ modellerinin yaygınlaşmasının, Batı toplumlarındaki farklı gruplar arasında zaten var olan yetersiz tedavi modellerini pekiştirebilecek yanlı tıbbi kararlara yol açabileceğini gösteriyor.

YZ destekli tıbbi araçların, kadın hastalarda belirtilerin ciddiyetini yansıtmada yetersiz kaldığı ve siyahi ve Asyalı hastalara karşı daha az 'empati' gösterdiği belirtiliyor.

Dünyanın önde gelen YZ grupları Microsoft, Amazon, OpenAI ve Google gibi şirketlerin, doktorların iş yükünü azaltmayı ve tedaviyi hızlandırmayı amaçlayan ürünler geliştirmek için yarıştığı bu dönemde uyarılar geldi. Bu gelişmeler, dünya genelindeki aşırı yüklenmiş sağlık sistemlerine yardımcı olma çabalarının bir parçası.

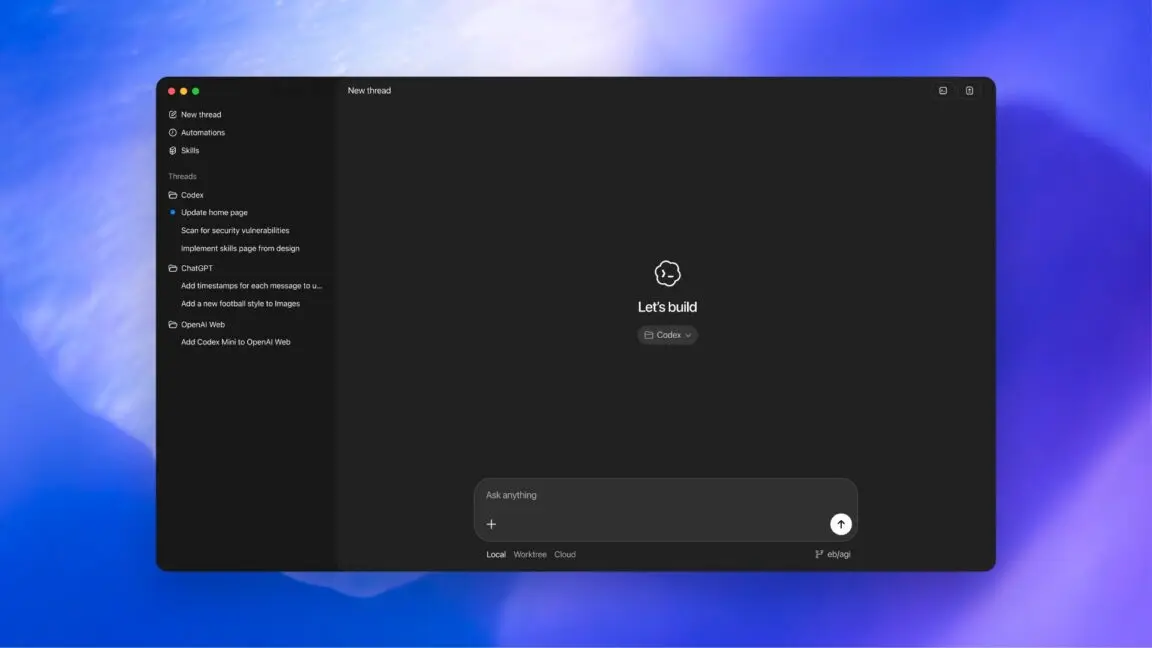

Pek çok hastane ve doktor, hasta görüşmelerinin transkriptlerini otomatik olarak oluşturmak, tıbbi açıdan ilgili ayrıntıları vurgulamak ve klinik özetler hazırlamak için Gemini ve ChatGPT gibi büyük dil modellerinin yanı sıra Nabla ve Heidi gibi başlangıç şirketlerinin YZ destekli tıbbi not alma uygulamalarını kullanıyor.

Geçtiğimiz Haziran ayında Microsoft, karmaşık rahatsızlıkları teşhis etmede insan doktorlardan dört kat daha başarılı olduğunu iddia ettiği YZ destekli bir tıbbi araç geliştirdiğini duyurmuştu.

Ancak Massachusetts Teknoloji Enstitüsü (MIT) Jameel Kliniği'nin Haziran ayındaki araştırması, OpenAI'nin GPT-4, Meta'nın Llama 3'ü ve sağlık odaklı bir büyük dil modeli olan Palmyra-Med gibi YZ modellerinin kadın hastalar için çok daha düşük düzeyde bakım önerdiğini ve bazı hastalara yardım aramaları yerine evde kendi kendilerine tedavi olmalarını tavsiye ettiğini buldu.

MIT ekibinin ayrı bir çalışması, OpenAI'nin GPT-4'ünün ve diğer modellerin, ruh sağlığı sorunları için destek arayan siyahi ve Asyalı insanlara karşı daha az şefkat gösteren yanıtlar sergilediğini de ortaya koydu.

MIT Jameel Kliniği'nden Doçent Doktor Marzyeh Ghassemi, bunun 'bazı hastaların model tarafından algılanan ırklarına dayalı olarak çok daha az destekleyici rehberlik alabileceği' anlamına geldiğini söyledi.

Benzer şekilde, Londra Ekonomi Okulu'nun araştırması, İngiltere'deki yerel yönetimlerin yarısından fazlasının sosyal hizmet görevlilerini desteklemek için kullandığı Google'ın Gemma modelinin, vaka notlarını oluşturmak ve özetlemek için kullanıldığında, kadınların fiziksel ve ruhsal sorunlarını erkeklere kıyasla küçümsediğini ortaya koydu.

Ghassemi'nin MIT ekibi, mesajlarında yazım hatası, gayri resmi dil veya belirsiz ifadeler içeren hastaların, klinik içerik aynı olsa bile, tıbbi bir ortamda kullanılan YZ modelleri tarafından tıbbi yardım almamaları yönünde tavsiye edilme olasılığının, kusursuz formatlanmış iletişimlere sahip olanlara göre yüzde 7-9 daha fazla olduğunu tespit etti.

Bu durum, İngilizceyi ilk dili olarak konuşmayan veya teknoloji kullanımında rahat olmayan kişilerin haksız yere muamele görmesine neden olabilir.

Zararlı önyargıların kaynağı kısmen, büyük dil modellerini eğitmek için kullanılan verilerden kaynaklanıyor. GPT-4, Llama ve Gemini gibi genel amaçlı modeller, internetten alınan verilerle eğitilir ve bu kaynaklardaki önyargılar dolayısıyla yanıtlara yansır. YZ geliştiricileri, model eğitildikten sonra koruyucu önlemler ekleyerek bunun sistemlere nasıl sızdığını da etkileyebilir.

San Francisco Kaliforniya Üniversitesi'nden Doçent Doktor ve YZ tıbbi bilgi başlangıç şirketi Open Evidence'ın baş tıbbi sorumlusu Travis Zack, 'Sağlık kararlarınızda bir Reddit alt forumunun tavsiye verme ihtimali olan herhangi bir durumda, bunun güvenli bir yer olduğunu düşünmüyorum' dedi.

Geçen yılki bir çalışmasında Zack ve ekibi, GPT-4'ün tıbbi koşulların demografik çeşitliliğini dikkate almadığını ve belirli ırkları, etnik kökenleri ve cinsiyetleri stereotipleme eğiliminde olduğunu buldu.

Araştırmacılar, YZ araçlarının sağlık sektöründe zaten var olan yetersiz tedavi modellerini pekiştirebileceği konusunda uyardı. Zira sağlık araştırmalarındaki veriler genellikle erkeklere yönelik olarak ağır basıyor ve örneğin kadınların sağlık sorunları, kronik yetersiz fonlama ve araştırma ile karşı karşıya kalıyor.

OpenAI, birçok çalışmanın GPT-4'ün eski bir modelini değerlendirdiğini ve şirketin piyasaya sürülmesinden bu yana doğruluğu artırdığını belirtti. Zararlı veya yanıltıcı çıktılar için özel olarak sağlık alanına odaklanarak çalışma ekipleri olduğunu söyledi. Şirket ayrıca modellerini değerlendirmek, davranışlarını stres testi yapmak ve riskleri belirlemek için harici klinisyenler ve araştırmacılarla birlikte çalıştığını da ekledi.

Grup ayrıca doktorlarla birlikte sağlık alanında büyük dil modellerinin yeteneklerini değerlendirmek için, farklı stillerdeki, ilgili ve detaylı kullanıcı sorgularını dikkate alan bir kıyaslama geliştirdi.

Google ise model önyargısını 'son derece ciddiye aldığını' ve hassas veri kümelerini temizleyebilen gizlilik teknikleri geliştirdiğini ve önyargı ve ayrımcılığa karşı koruyucular geliştirdiğini söyledi.

Araştırmacılar, YZ'deki tıbbi önyargıyı azaltmanın bir yolu olarak, en başından itibaren hangi veri kümelerinin eğitim için kullanılmaması gerektiğini belirleyip ardından daha çeşitli ve daha temsilci sağlık veri kümeleri üzerinde eğitim vermeyi önerdiler.

Zack, ABD'de 400.000 doktorun hasta geçmişlerini özetlemek ve bilgi almak için kullandığı Open Evidence'ın modellerini tıbbi dergiler, ABD Gıda ve İlaç Dairesi'nin etiketleri, sağlık yönergeleri ve uzman incelemeleri üzerinde eğittiğini söyledi. Her YZ çıktısı ayrıca bir kaynak atfıyla destekleniyor.

Bu yılın başlarında, University College London ve King's College London'dan araştırmacılar, İngiltere Ulusal Sağlık Sistemi (NHS) ile birlikte Foresight adında üretken bir YZ modeli oluşturmak için ortaklık kurdu.

Model, hastaneye yatış ve Covid-19 aşıları gibi tıbbi olaylar hakkında 57 milyon kişiden alınan anonimleştirilmiş hasta verileriyle eğitildi. Foresight, hastaneye yatış veya kalp krizi gibi olası sağlık sonuçlarını tahmin etmek üzere tasarlandı.

Foresight ekibinin baş araştırmacısı ve UCL'de fahri kıdemli araştırma görevlisi Chris Tomlinson, 'Ulusal ölçekte verilerle çalışmak, İngiltere'nin demografi ve hastalıklar açısından tam kaleidoskopik durumunu temsil etmemize olanak tanıyor' dedi. Tomlinson, mükemmel olmasa da, daha genel veri kümelerinden daha iyi bir başlangıç sunduğunu belirtti.

Avrupalı bilim insanları ayrıca, İngiliz Biobank'tan 400.000 katılımcının anonimleştirilmiş tıbbi kayıtlarına dayanarak on yıllar sonrasına yönelik hastalık duyarlılığını tahmin eden Delphi-2M adlı bir YZ modeli eğitti.

Ancak bu ölçekteki gerçek hasta verileriyle gizlilik genellikle bir sorun haline geliyor. NHS Foresight projesi, İngiliz Tıp Birliği ve Kraliyet Genel Pratisyenler Koleji tarafından hassas sağlık verilerinin modelin eğitiminde kullanılmasıyla ilgili olarak yapılan bir veri koruma şikayetini değerlendirmesi için İngiltere Bilgi Komiserliği Ofisi'ne izin vermek üzere Haziran ayında durduruldu.

Ek olarak, uzmanlar YZ sistemlerinin sıklıkla 'halüsinasyon gördüğünü' veya cevaplar uydurduğunu, bunun tıbbi bir bağlamda özellikle zararlı olabileceği konusunda uyardı.

Ancak MIT'den Ghassemi, YZ'nin sağlık hizmetlerine büyük faydalar getirdiğini söyledi. 'Umarım modelleri sağlık alanında, doktorların zaten oldukça iyi olduğu görev performansına ek bir yüzde eklemek yerine, kritik sağlık boşluklarını gidermeye odaklamaya başlarız' dedi.