Nvidia'nın yapay zeka alanındaki son gelişmeleri, büyük dil modellerinin (LLM) eğitimi konusunda önemli yenilikler sunuyor. Şirket, bu yılın başlarında duyurduğu 4-bit kayan nokta formatı NVFP4'ün, özellikle LLM eğitiminde önemli avantajlar sağladığını bilimsel bir makale ile detaylandırdı. Bu yeni formatın, mevcut FP8 ve BF16 gibi formatlara göre daha verimli olabileceği belirtiliyor.

Nvidia, 12 milyar parametreli bir modelin, 10 trilyon token'lık devasa bir veri seti üzerinde NVFP4 formatı kullanılarak eğitildiğini ve bu süreçte önemli bir doğruluk kaybı yaşanmadığını gösterdi. Bu başarı, FP4 hassasiyetinde büyük ölçekli ve kararlı bir eğitimin ilk örneği olarak kayıtlara geçiyor. NVFP4, bellek kullanımını ve hesaplama maliyetini önemli ölçüde azaltırken, model kalitesinden ödün vermiyor.

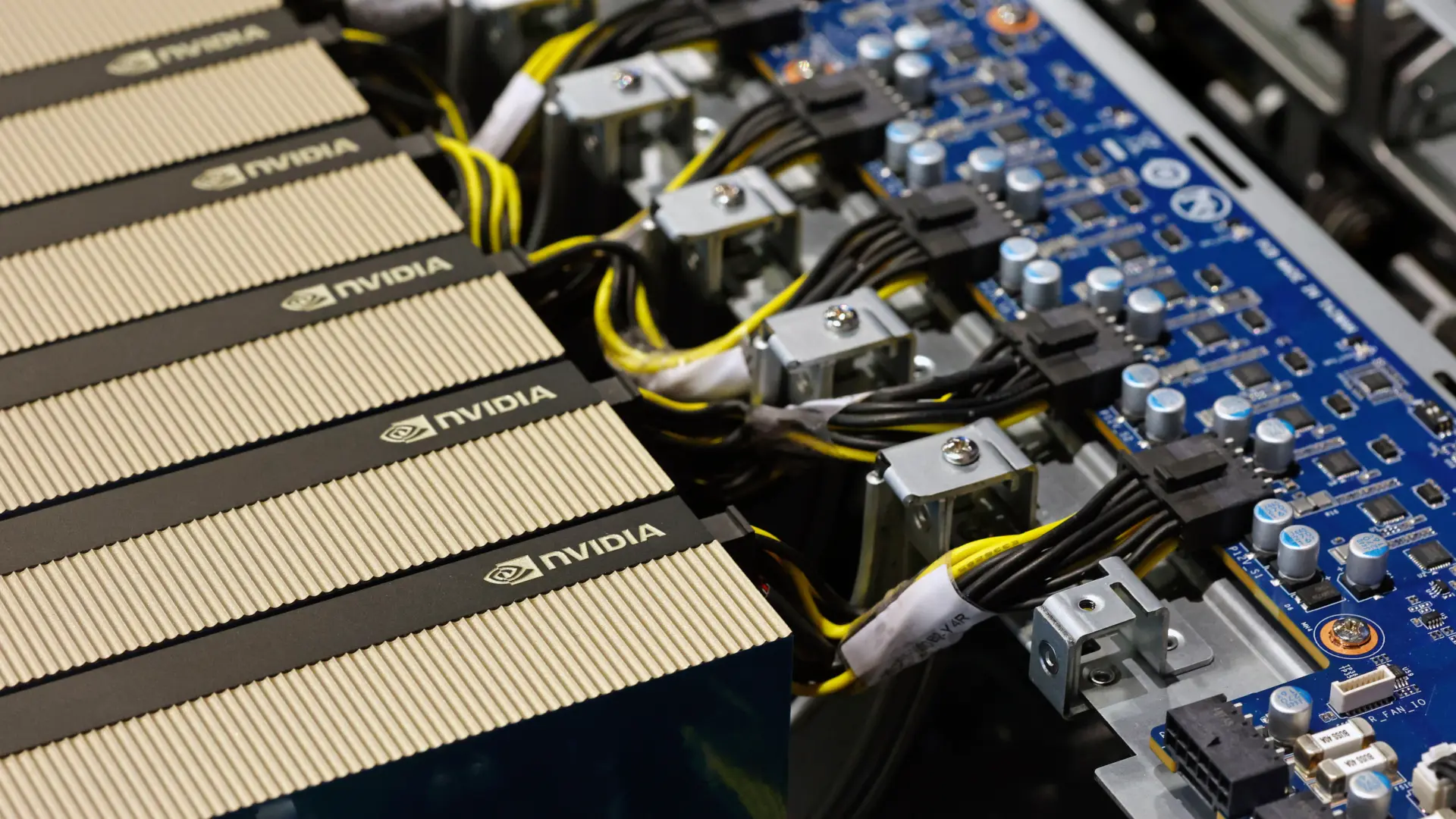

Blackwell ve NVFP4: Mükemmel Uyum

Nvidia'nın Blackwell GPU mimarisi için özel olarak geliştirdiği NVFP4 formatı, hem eğitim hem de çıkarım (inference) görevlerinde verimliliği artırmayı hedefliyor. Bu format, sıkı veri temsili ile çok seviyeli ölçeklendirme stratejisini birleştirerek, BF16'ya yakın doğruluk seviyeleri sunarken, performans ve bellek gereksinimlerini önemli ölçüde düşürüyor.

NVFP4, standart FP4 formatlarının E2M1 düzenine (1 işaret biti, 2 üs biti, 1 kesir biti) uyuyor ve yaklaşık -6 ile +6 arasındaki değerleri kodlayabiliyor. 4-bit formatlarının doğasında var olan sınırlı dinamik aralığın üstesinden gelmek için Nvidia, hiyerarşik bir ölçeklendirme mekanizması sunuyor. Her 16 elemanlık FP4 değeri bloğu için E4M3 düzeninde bir FP8 ölçek faktörü belirleniyor ve aynı zamanda tüm tensör boyunca küresel bir FP32 ölçek faktörü uygulanıyor. Bu iki katmanlı sistemin, sayısal gürültüyü düşük tutarken 4-bit formatının sunduğu performans verimliliğinden ödün vermediği iddia ediliyor.

Nvidia'nın en yeni Blackwell GPU'ları, MXFP8, MXFP6, MXFP4 ve NVFP4 gibi dar formatlarda genel matris çarpımı (GEMM) yapabilen tensör çekirdeklerine sahip. Blackwell tensör çekirdekleri, GEMM işlemlerini, önce girdi değerlerinin her bloğuna bir ölçek faktörü uygulayarak, ardından nokta çarpımı hesaplamalarını yüksek hassasiyette yürüterek ve sonuçları FP32 seviyesinde bir doğrulukla biriktirerek gerçekleştiriyor. NVFP4'ün de bu şekilde kullanılması planlanıyor.

Bu çekirdekler, FP4 gibi düşük hassasiyetli formatlarla kararlı eğitim sağlamak için önemli olan yuvarlamaya en yakın çift sayı ve stokastik yuvarlama gibi yerleşik yuvarlama yöntemlerini de destekliyor. Nvidia'ya göre, NVFP4 işlemleri GB200'de BF16'ya göre 4 kat, GB300'de ise 6 kat daha hızlı çalışıyor. Ayrıca, bellek tüketimi FP8'e kıyasla yaklaşık yarı yarıya azalıyor.

Eğitimde Kullanılabilir mi?

Model Kurulumu ve Eğitim Yaklaşımı

NVFP4'ün verimliliğini değerlendirmek için Nvidia, hibrit bir Mamba-Transformer mimarisine dayanan 12 milyar parametreli bir büyük dil modelini eğitti. Bu model mimarisi, Nemotron-H ailesinden geliyordu ve Mamba-2 blokları, standart ileri beslemeli katmanlar ve kendi kendine dikkat modüllerini içeriyordu. Eğitim, bir ısınma-stabilizasyon-azaltma (warmup-stable-decay) programı izledi: öğrenme oranı, çalışmanın ilk %80'i boyunca sabit kaldı ve son %20'lik dilimde kademeli olarak azaltıldı.

NVFP4'ün LLaMA, OpenAI'nin GPT'si ve diğer Transformer tabanlı LLM'ler gibi modellere uygulanabileceği unutulmamalıdır; bu format kesinlikle gösterimde kullanılan Mamba-Transformer mimarisine özgü değildir. Ancak, modelin düşük hassasiyetli formatlar için orijinal olarak tasarlanmadığı durumlarda, BF16 katmanlarının sayısını ayarlamak, blok ölçeklendirme seçimlerini doğrulamak ve nicemleme duyarlı eğitim gerçekleştirmek gerekebilir.

Her eğitim dizisi 8192 token içeriyordu ve toplu iş boyutu (batch size) 736 olarak ayarlandı. Eğitim için kullanılan veri seti, genel internet metinleri, programlama kodları, matematik problemleri, çok dilli derlemler, akademik makaleler ve sentetik talimat ayarlı örnekler dahil olmak üzere çeşitli içerik türlerinin dengeli bir karışımından oluşuyordu. Eğitim sırasında çeşitli veri türlerine dengeli maruz kalmayı sağlamak için karıştırma üç aşamada gerçekleştirildi.

FP8 ile Karşılaştırıldığında Doğruluk

Eğitim boyunca, NVFP4 ile eğitilen model, doğrulama kaybı (validation loss) açısından FP8 temel çizgisine çok yakından takip etti. Nvidia'ya göre, çalıştırmanın büyük bir bölümünde NVFP4 ve FP8 arasındaki kayıp farkı %1'in altında kaldı, öğrenme oranının düşmeye başlamasıyla sona doğru %1.5'in biraz üzerine çıktı. Ancak bu küçük kayıp artışı, ölçülebilir bir görev doğruluğu düşüşüne yol açmadı.

NVFP4, sağduyu akıl yürütme, matematik, bilgi yoğun sorular ve çok dilli kıyaslamalar dahil olmak üzere geniş bir yelpazedeki aşağı akış görevlerinde FP8 ile karşılaştırılabilir sonuçlar elde etti. Örneğin, NVFP4, MMLU-Pro 5-shot kıyaslamasında %62.58'e ulaşarak FP8 sonucunu olan %62.62'yi neredeyse yakaladı. Tek dikkat çekici doğruluk düşüşü, MBPP+ ve HumanEval+ gibi kodla ilgili görevlerde meydana geldi; burada NVFP4 birkaç yüzde puanı geride kaldı. Ancak, bu tutarsızlık, formatta sistemik bir kusurdan ziyade normal kontrol noktası değişkenliğine bağlandı.

Kararlı 4-bit Eğitim İçin Teknikler

FP4 hassasiyetiyle büyük modelleri eğitmek, kararlılık ve doğruluğu sağlamak için çeşitli ayarlamalar gerektirir. Ana stratejilerden biri, ağırlıklı olarak modelin son bloklarındaki doğrusal katmanların yaklaşık %15'ini BF16'da tutmaktır. Tüm katmanlarda NVFP4 kullanmak ayrışmaya yol açarken, Nvidia sadece son dört bloğu BF16'da tutmanın bile kararlı eğitim için yeterli olduğunu buldu. Bu durum, BF16 ayak izinin daha da azaltılabileceğini ima ediyor.

İleri ve geri geçişler (ters çevrilmiş ağırlıkları kullanan) arasındaki tutarlılığı korumak için Nvidia, ağırlıklar için 2D blok ölçeklendirme kullandı: ağırlıklar, her iki yönde de uygulanan paylaşılan bir ölçek faktörü ile 16x16 bloklara ayrıldı. Aktivasyonlar ve gradyanlar için, daha ince 1x16 blok ölçeklendirme kullanıldı, bu da kararsızlık yaratmadan nicemleme doğruluğunu artırdı.

Gradyanlardaki aykırı değerlerle başa çıkmak için Nvidia, yeniden dağıtılmış büyük değerleri daha eşit bir şekilde dönüştürmek ve FP4'te temsil edilmelerini kolaylaştırmak amacıyla ağırlık gradyanı (Wgrad) girdilerine Rastgele Hadamard Dönüşümleri uyguladı. Ancak, bu tür dönüşümler diğer tensör türlerine uygulanmadı ve tüm katmanlarda paylaşılan rastgele bir işaret vektörü ile 16x16'lık bir matris kullanıldı.

Son olarak, gradyan nicemlemesi için donanım hızlandırmalı stokastik yuvarlama kullanıldı. Bu, eğitim sırasında birikebilen yuvarlama yanlılığını önlemeye yardımcı oldu. Ayrıca, Nvidia bunu yalnızca gradyanlara uyguladı, çünkü ileri aktivasyonlara uygulanması gürültüyü artırdı ve eğitim kalitesini düşürdü.

Geç Aşamada Hassasiyet Değiştirme

Nihai kaybı en aza indirmenin kritik olduğu senaryolarda, Nvidia, eğitimin geç aşamalarında NVFP4'ten BF16'ya geçişi test etti. 8.2 trilyon token'da yapılan bir geçiş, nihai kayıptaki farkı önemli ölçüde azalttı. Yalnızca ileri geçişi BF16'ya geçirmek, hem ileri hem de geri geçişleri değiştirmekle neredeyse aynı etkiyi yarattı. Buna karşılık, 10 trilyon token'da -eğitimin sonuna doğru- yapılan bir geçiş, zaten düşük olan öğrenme oranı nedeniyle minimal bir etki yarattı. Bu sonuçlar, eğitimin sonuna yakın yüksek hassasiyetin sınırlı kullanımının, FP4'ün verimlilik faydalarının çoğunu korurken doğruluğu artırabileceğini gösteriyor.

NVFP4 vs. MXFP4

Daha yaygın olan MXFP4 formatı ile (Açık Hesaplama Projesi tarafından tanımlanan ve Huawei'nin Ascend 950 serisi işlemcilerinde ve sonrasında desteklenen) NVFP4'ü karşılaştırmak için Nvidia, aynı 1 trilyon token'lık veri seti üzerinde her iki formatı kullanarak 8 milyar parametreli bir model eğitti. NVFP4, BF16 referansının yaklaşık %1.5 üzerinde nihai bir kayıp elde ederken, MXFP4'ün nihai kaybı %2.5 civarındaydı. NVFP4'ün nihai kaybını eşleştirmek için MXFP4 modelinin 1.36 trilyon token'a, yani %36 daha fazla veriye ihtiyacı oldu.

Yapay Zeka Eğitimi NVFP4'ten Faydalanıyor

Nvidia'nın kendi testlerine göre, NVFP4 formatı, 4-bit hassasiyeti kullanarak büyük ölçekli LLM'lerin doğru, kararlı ve verimli bir şekilde eğitilmesini sağlıyor. Daha hassas bir nicemleme formatını, karma hassasiyet, tutarlı ölçeklendirme, stokastik yuvarlama ve aykırı değer işleme gibi tekniklerle birleştirerek, şirket 10 trilyon token'lık bir set üzerinde öncü sınıf bir 12B modeli başarıyla eğitti.

MXFP4 formatıyla karşılaştırıldığında, NVFP4 hem yakınsama hem de veri verimliliği açısından onu geride bırakıyor.

Nvidia'nın gelecekteki çalışmaları, yüksek hassasiyetli katmanların sayısını daha da azaltmaya, NVFP4'ü daha fazla model bileşenine genişletmeye ve daha büyük modeller ile alternatif mimilerdeki etkinliğini değerlendirmeye odaklanacak.