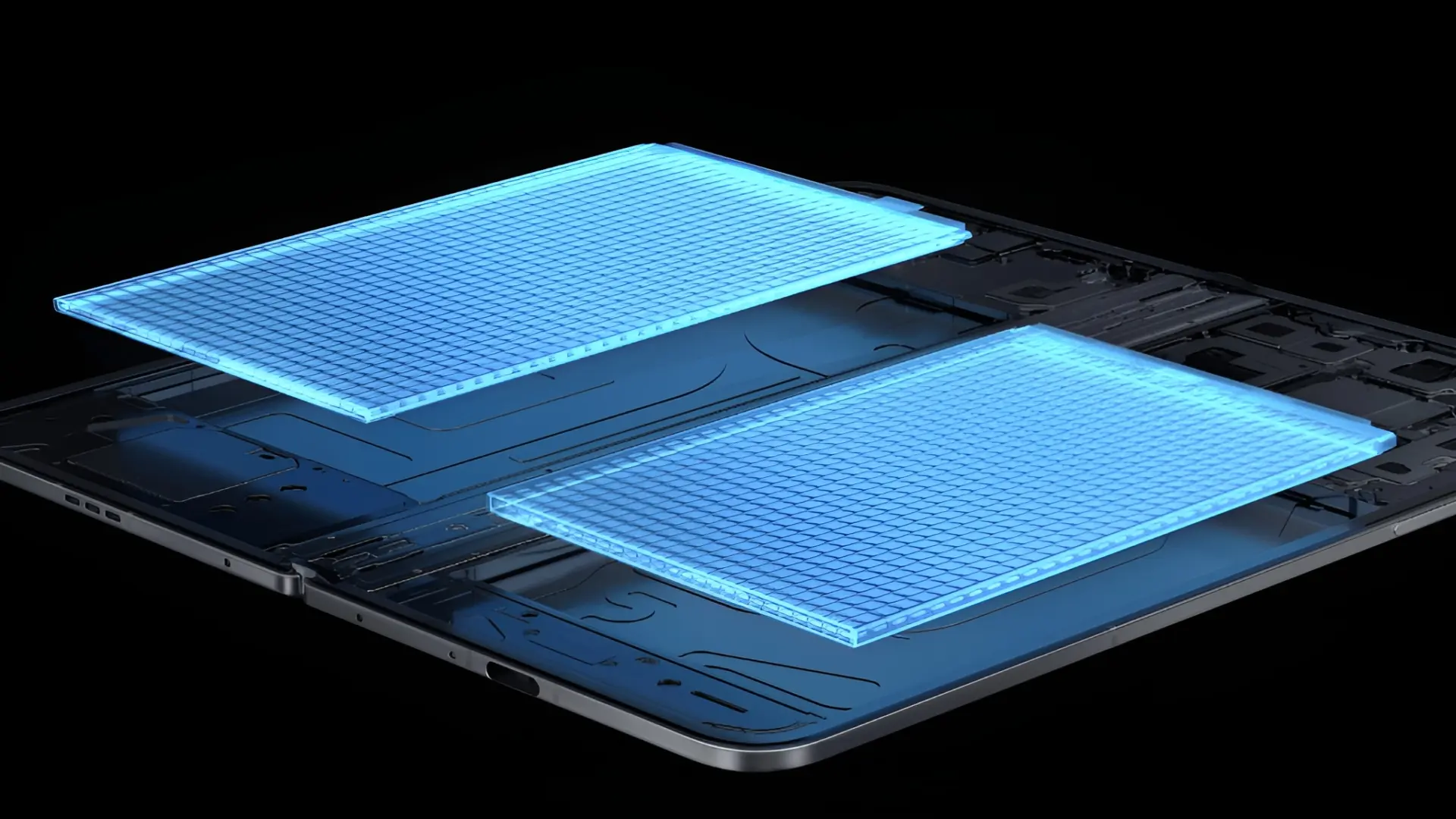

NVIDIA, gelecekteki 'Feynman' kod adlı GPU'larında Groq'un LPU (Dil İşleme Birimi) teknolojisini entegre ederek yapay zeka çıkarım pazarında liderliği pekiştirmeyi hedefliyor. Bu entegrasyonun, AMD'nin X3D işlemcilerinde kullandığına benzer bir yaklaşımla, ayrı çiplerin üst üste istiflenmesi şeklinde gerçekleşebileceği düşünülüyor.

NVIDIA, LPU Entegrasyonu İçin Hibrit Bağlantıyı Kullanabilir mi?

NVIDIA'nın Groq'un LPU birimleri için aldığı lisans, ilk bakışta küçük bir gelişme gibi görünse de, aslında şirketin yapay zeka çıkarım alanında LPU'lar aracılığıyla liderlik kurma stratejisinin bir parçası olarak değerlendiriliyor. LPU'ların nasıl entegre edileceğine dair çeşitli senaryolar ortaya atılsa da, uzmanların görüşlerine göre, LPU birimleri yeni nesil 'Feynman' GPU'larına TSMC'nin hibrit bağlantı teknolojisiyle üst üste eklenebilir.

Bu yaklaşımın, AMD'nin X3D işlemcilerinde ana işlemci çekirdeğinin üzerine 3D V-Cache parçacıklarını entegre etmek için kullandığı TSMC'nin SoIC hibrit bağlantı teknolojisine benzediği belirtiliyor. Uzmanlar, SRAM'ın tek parça bir çip olarak entegre edilmesinin 'Feynman' GPU'ları için doğru bir hamle olmayabileceğini, zira SRAM ölçeklenmesinin sınırlı olduğunu ve gelişmiş düğümlerde üretilmesinin yüksek maliyetli silikonun israfına yol açabileceğini savunuyor. Bunun yerine, NVIDIA'nın LPU birimlerini 'Feynman' işlemci yongasının üzerine istifleyeceği öngörülüyor.

Bu strateji oldukça mantıklı görünüyor. Zira ana işlemci çekirdeğini (hesaplama blokları, kontrol mantığı vb. içeren) A16 (1.6nm) gibi gelişmiş bir düğümde üreten NVIDIA, büyük SRAM bankalarını içeren ayrı LPU yongalarını kullanabilir. Bu yongaları birbirine bağlamak için TSMC'nin hibrit bağlantı teknolojisi kritik öneme sahip olacak. Bu teknoloji, paket dışı belleklere kıyasla daha geniş bir arayüz ve daha düşük bit başına enerji kullanımı sağlayacak. Ayrıca, A16'nın arka yüzey güç dağıtımı özelliğine sahip olması, ön yüzeyin dikey SRAM bağlantıları için serbest kalmasını sağlayarak düşük gecikmeli bir yanıt süresi sunacak.

Ancak bu teknikle birlikte termal yönetim konusunda bazı endişeler de söz konusu. Yüksek hesaplama yoğunluğunda çalışan bir işlemde yongaları üst üste istiflemek zaten bir zorlukken, sürekli yüksek işlem hacmine odaklanan LPU'ların eklenmesi darboğazlara yol açabilir. Daha da önemlisi, bu tür bir yaklaşımla yürütme seviyesindeki etkiler de önemli ölçüde artacaktır. LPU'lar sabit bir yürütme sırasına odaklandığı için, determinizm ve esneklik arasında bir çatışma oluşabilir.

NVIDIA donanım seviyesindeki kısıtlamaları aşmayı başarsa bile, asıl endişe CUDA'nın LPU benzeri yürütme içindeki davranışıyla ilgili. CUDA, bellek yerleşimini açıkça belirtmeyi gerektirirken, CUDA çekirdekleri donanım soyutlaması için tasarlanmıştır. Yapay zeka mimarilerine SRAM entegre etmek NVIDIA için kolay bir görev olmayacak ve LPU-GPU ortamlarının iyi optimize edildiğinden emin olmak mühendislik harikası gerektirebilir. Ancak, yapay zeka çıkarım pazarında lider olmak isteyen NVIDIA'nın ödemeye razı olabileceği bedel bu olabilir.