Son yıllarda, yayınevleri, gazete ve dergiler, yazılım geliştiricileri ve fotoğraf sanatçıları dahil olmak üzere pek çok telif hakkı sahibi, AI şirketlerine telifli materyalleri kullanarak model eğittikleri için dava açtı. Bu davalardaki temel sorulardan biri, yapay zeka modellerinin telifli içeriklerden kelimesi kelimesine alıntılar üretme kolaylığıydı.

Örneğin, büyük bir AI şirketine karşı açılan bir davada, şirketin önde gelen bir modelinin bir gazetenin haberlerinden önemli pasajları birebir tekrarladığına dair düzinelerce örnek sunulmuştu. Şirket, bunun "uç bir davranış" ve "araştırmacıların düzeltmek için yoğun çaba harcadığı bir sorun" olduğunu iddia etmişti.

Peki, bu gerçekten uç bir davranış mı? Ve önde gelen AI şirketleri bu sorunu çözdü mü? Yeni bir araştırma, gazete makalelerinden ziyade kitaplara ve farklı şirketlerin modellerine odaklanarak bu soruya şaşırtıcı yanıtlar veriyor. Bulgulardan bazıları dava açanların argümanlarını güçlendirirken, bazıları da davalı şirketlere yardımcı olabilir.

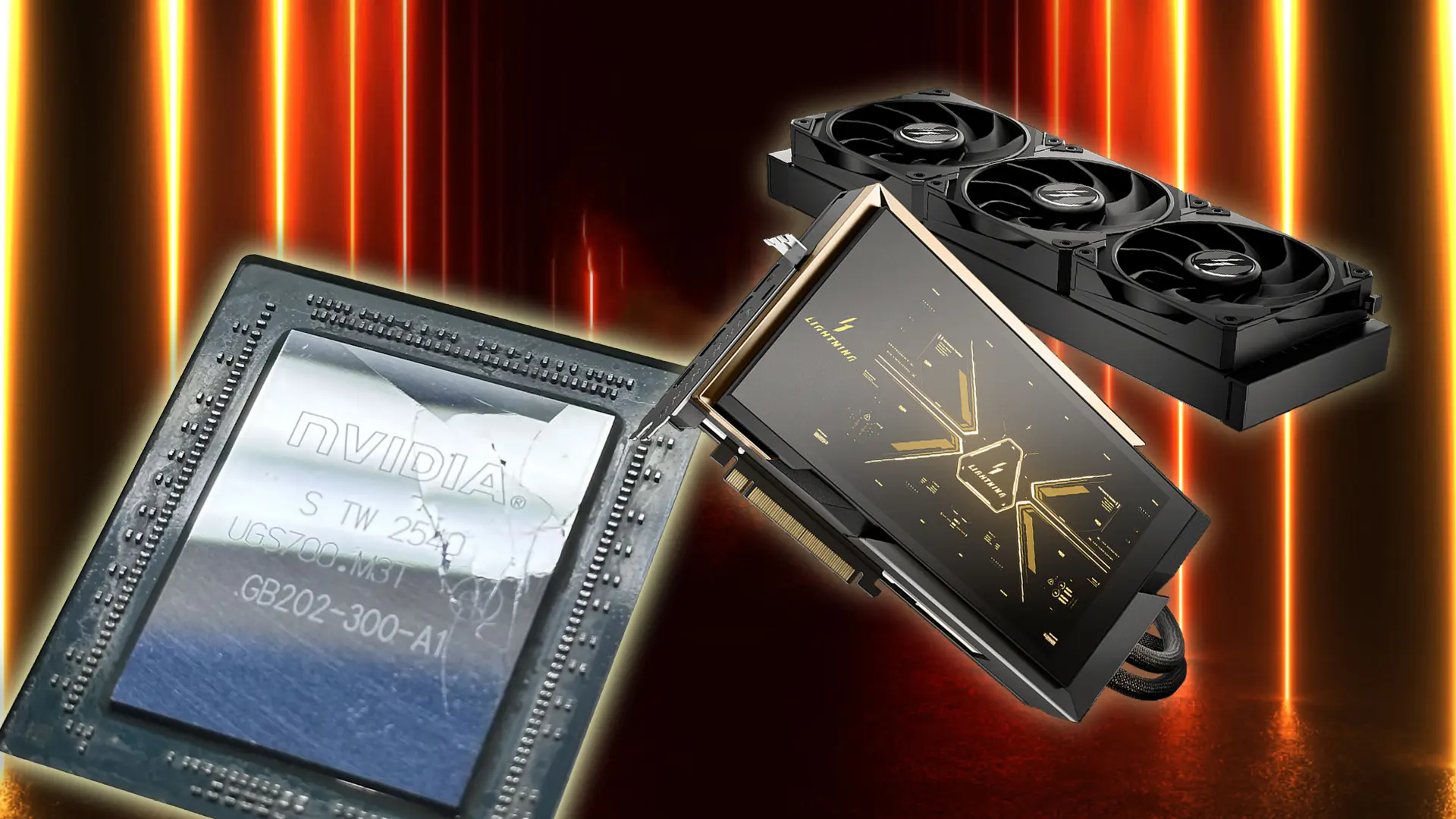

Geçtiğimiz ay yayınlanan bir makale, önde gelen üniversitelerden bilgisayar bilimcileri ve hukuk uzmanları tarafından yapıldı. Çalışmada, Meta'dan üç ve diğer şirketlerden iki olmak üzere beş popüler açık kaynaklı modelin, büyük dil modellerini eğitmek için yaygın olarak kullanılan ve çoğu hala telif hakkı altında olan bir kitap koleksiyonundaki metinleri yeniden üretme yetenekleri incelendi.

Araştırmanın en şaşırtıcı bulgusu şu şekilde özetlenebilir: Farklı modellerin, popüler bir kitabın çeşitli bölümlerinden 50 kelimelik pasajları ne kadar kolay yeniden üretebildiği incelendi. Tablolar, belirli bir modelin kitabın o kısmını yeniden üretme olasılığının ne kadar yüksek olduğunu gösteriyordu. İncelenen Meta modellerinden biri olan Llama 3.1 70B (Meta'nın 2024 Temmuz'unda yayınladığı orta ölçekli bir model), diğer dört modele kıyasla Harry Potter metinlerini yeniden üretme olasılığının çok daha yüksek olduğunu ortaya koydu.

Spesifik olarak, makale, Llama 3.1 70B'nin ilk Harry Potter kitabının tam yüzde 42'sini, 50 kelimelik alıntıları en az yarısında birebir üretebilecek kadar ezberlediğini tahmin ediyor. İlginç bir şekilde, Meta'nın Şubat 2023'te piyasaya sürdüğü benzer büyüklükteki Llama 1 65B modeli, aynı kitabın yalnızca yüzde 4.4'ünü ezberlemişti. Bu durum, potansiyel yasal sorumluluğa rağmen Meta'nın Llama 3'ü eğitirken ezberlemeyi önlemek için pek bir şey yapmadığını düşündürüyor. En azından bu kitap için sorun, Llama 1 ile Llama 3 arasında çok daha kötüleşmiş görünüyor.

Harry Potter serisinin ilk kitabı, araştırmacılar tarafından test edilen düzinelerce kitaptan sadece biriydi. Llama 3.1 70B'nin, popüler kitapları (örneğin, Yüzüklerin Efendisi'nin öncesini anlatan bir kitap ve klasik bir distopya romanı) nadir bulunanlara göre çok daha kolay yeniden ürettiği belirlendi. Ve çoğu kitap için Llama 3.1 70B, diğer tüm modellerden daha fazla ezber yapmıştı.

Araştırmanın yazarlarından biri, modeller arasında ne kadar kelimesi kelimesine metin ezberledikleri konusunda gerçekten çarpıcı farklılıklar olduğunu belirtti. Sonuçlar, araştırmayı yapan akademisyenleri de şaşırttı. İlk başta yüzde 1 veya 2 gibi düşük bir yeniden üretilebilirlik seviyesi beklediklerini, ancak ilk şaşırtıcı şeyin varyasyonun ne kadar yüksek olduğu olduğunu söylediler.

Bu sonuçlar, AI telif hakkı tartışmasındaki herkese tutunacak bir dal veriyor. AI endüstrisi eleştirmenleri için büyük çıkarım, en azından bazı modeller ve bazı kitaplar için ezberlemenin uç bir olgu olmadığıdır.

Öte yandan, çalışma sadece birkaç popüler kitabın önemli ölçüde ezberlendiğini buldu. Örneğin, Llama 3.1 70B'nin nispeten daha az bilinen bir romanın yalnızca yüzde 0.13'ünü ezberlediği görüldü. Bu, Harry Potter için elde edilen yüzde 42'lik rakamın çok küçük bir kısmı.

Bu tür farklı sonuçlar, AI şirketlerine karşı toplu davalar açan hukuk firmaları için bir baş ağrısı olabilir. Bir toplu dava açmak için, mahkemenin davacıların büyük ölçüde benzer hukuki ve fiili durumlarda olduğunu tespit etmesi gerekir. Bu tür çelişkili sonuçlar, binlerce yazarın tek bir toplu davada bir araya getirilmesinin mantıklı olup olmadığı konusunda şüphe uyandırabilir. Bu da çoğu yazarın bireysel dava açacak kaynaklara sahip olmaması nedeniyle AI şirketlerinin lehine çalışabilir.

Bu çalışmanın daha geniş dersi, bu telif hakkı davalarında ayrıntıların önemli olacağıdır. Çoğu zaman, çevrimiçi tartışmalar, "üretici modeller eğitim verilerini kopyalar mı yoksa sadece onlardan öğrenir mi?" sorusunu teorik, hatta felsefi bir soru olarak ele almıştır. Ancak bu, ampirik olarak test edilebilen bir sorudur ve cevabı modellere ve telifli eserlere göre değişebilir.

Ezberleme Nasıl Ölçüldü?

Büyük dil modellerinin bir sonraki kelimeyi tahmin ettiğinden bahsetmek yaygındır. Ancak modelin arka planda yaptığı şey, bir sonraki kelime için tüm olasılıklar üzerinde bir olasılık dağılımı oluşturmaktır. Örneğin, bir modele "Fıstık ezmesi ve" ifadesini girdiğinizde, model hayali bir örnekte şöyle görünebilecek bir olasılık dağılımıyla yanıt verecektir:

- P("reçel") = %70

- P("şeker") = %9

- P("fıstık") = %6

- P("çikolata") = %4

- P("krema") = %3

Ve bu şekilde devam eder.

Model bu tür bir olasılık listesi oluşturduktan sonra, sistem bu seçeneklerden birini rastgele, olasılıklarına göre ağırlıklandırarak seçecektir. Yani sistem zamanın %70'inde "Fıstık ezmesi ve reçel" üretecektir. Zamanın %9'unda "Fıstık ezmesi ve şeker" elde edeceğiz. Zamanın %6'sında "Fıstık ezmesi ve fıstık" olacaktır. Fikri anladınız.

Çalışmanın yazarları, belirli bir yanıtın olasılığını tahmin etmek için birden fazla çıktı üretmek zorunda kalmadılar. Bunun yerine, her kelime için olasılıkları hesaplayıp sonra bunları çarparak ilerlediler.

Diyelim ki biri bir modelin "En sevdiğim sandviç" ifadesine "fıstık ezmesi ve reçel" ile yanıt verme olasılığını tahmin etmek istiyor. Bunu şu şekilde yapabilirler:

- Modeli "En sevdiğim sandviç" ile başlatıp, "fıstık" kelimesinin olasılığını arayın (diyelim ki %20).

- Modeli "En sevdiğim sandviç fıstık" ile başlatıp, "ezmesi" kelimesinin olasılığını arayın (diyelim ki %90).

- Modeli "En sevdiğim sandviç fıstık ezmesi" ile başlatıp, "ve" kelimesinin olasılığını arayın (diyelim ki %80).

- Modeli "En sevdiğim sandviç fıstık ezmesi ve" ile başlatıp, "reçel" kelimesinin olasılığını arayın (diyelim ki %70).

Sonra sadece olasılıkları şöyle çarpmalıyız:

0.2 * 0.9 * 0.8 * 0.7 = 0.1008

Böylece modelin "fıstık ezmesi ve reçel"i yaklaşık %10 olasılıkla üreteceğini tahmin edebiliriz, aslında 100 veya 1.000 çıktı üretmeden ve tam olarak o ifade olanları saymadan.

Bu teknik, araştırmanın maliyetini önemli ölçüde azalttı, yazarların daha fazla kitabı analiz etmesine olanak tanıdı ve çok düşük olasılıkları hassas bir şekilde tahmin etmeyi mümkün kıldı.

Örneğin, yazarlar bazı kitaplardan alınan bazı 50 kelimelik dizileri birebir yeniden üretmenin 10 katrilyondan fazla örnek gerektireceğini tahmin ettiler. Açıkçası, bu kadar çok çıktı üretmek mümkün olmazdı. Ancak gerekli de değildi: olasılık, sadece 50 kelime için olasılıkları çarparak tahmin edilebilirdi.

Dikkat edilmesi gereken önemli bir husus, olasılıkların çok hızlı bir şekilde gerçekten küçük olabileceğidir. Benim hayali örneğimde, modelin dört kelimeyi ("fıstık ezmesi ve reçel") üretme olasılığı sadece %10'dur. Daha fazla kelime ekleseydik, olasılık daha da düşerdi. Eğer 46 kelime daha ekleseydik, olasılık birkaç büyüklük mertebesi düşebilirdi.

Herhangi bir dil modeli için, herhangi bir 50 kelimelik diziyi "kazara" üretme olasılığı yok denecek kadar küçüktür. Eğer bir model telifli bir eserden 50 kelime üretirse, bu, kelimelerin eğitim verilerinden "geldiğine" dair güçlü bir kanıttır. Bu, modeli bu kelimeleri yalnızca %10, %1 veya %0.01 oranında üretiyor olsa bile geçerlidir.

Harry Potter Metinlerinin Llama Modellerine Nasıl Girdiği Bilinmiyor

Çalışma yazarları 36 kitabı aldı ve her birini örtüşen 100 kelimelik pasajlara ayırdı. İlk 50 kelimeyi bir istek (prompt) olarak kullanarak, sonraki 50 kelimenin orijinal pasajla aynı olma olasılığını hesapladılar. Modelin kelimesi kelimesine yeniden üretme olasılığı yüzde 50'den büyükse, bir pasajı "ezberlenmiş" saydılar.

Bu tanım oldukça katıdır. 50 kelimelik bir dizinin olasılığının yüzde 50'den büyük olması için, pasajdaki ortalama bir kelimenin olasılığının en az yüzde 98.5 olması gerekir! Ayrıca, yazarlar yalnızca tam eşleşmeleri saydılar. Örneğin, modelin orijinal pasajdan 48 veya 49 kelime ürettiği ancak bir veya iki kelimeyi yanlış yazdığı durumları saymaya çalışmadılar. Eğer bu durumlar sayılmış olsaydı, ezberleme miktarı daha da yüksek olurdu.

Bu araştırma, Harry Potter serisinin ilk kitabının önemli kısımlarının Llama 3.1 70B'nin ağırlıklarına kopyalandığına dair güçlü kanıtlar sunuyor. Ancak bu bulgu, bunun neden veya nasıl olduğunu bize söylemiyor. Bunun bir kısmının, Llama 3 70B'nin, Llama 1 65B'yi eğitmek için kullanılan 1.4 trilyon kelimenin 10 katından fazla olan 15 trilyon kelime üzerinde eğitilmiş olmasından kaynaklandığını düşünüyorum.

Bir model belirli bir örnek üzerinde ne kadar çok eğitilirse, o örneği ezberleme olasılığı o kadar artar. Belki de Meta, 15 trilyon farklı kelime bulmakta zorlandı ve bu nedenle Books3 veri setini birden çok kez eğitti. Ya da belki Meta, çevrimiçi Harry Potter hayran forumları, tüketici kitap incelemeleri veya öğrenci kitap raporları gibi, Harry Potter ve diğer popüler kitaplardan alıntılar içeren üçüncü taraf kaynaklar eklemiştir.

Bu açıklamaların ikisinin de gerçeklere tam olarak uyduğundan emin değilim. En popüler kitaplar için ezberlemenin çok daha büyük bir sorun olduğu gerçeği, Llama'nın kitapların kendilerinden ziyade bu kitaplardan alıntı yapan ikincil kaynaklar üzerinde eğitilmiş olabileceğini düşündürüyor. Çevrimiçi Harry Potter tartışmalarının, diğer bazı daha az bilinen kitaplara göre katlanarak daha fazla olması muhtemeldir.

Öte yandan, Llama'nın ilk Harry Potter kitabının bu kadar büyük bir kısmını ezberlemesi şaşırtıcıdır.

Bir hukuk uzmanı, eğer bunlar atıflar ve alıntılar olsaydı, herkesin alıntıladığı veya bahsettiği birkaç popüler şey etrafında yoğunlaşmasını bekleyeceğini belirtti. Llama 3'ün kitabın neredeyse yarısını ezberlemesi, tüm metnin eğitim verilerinde iyi temsil edildiğini düşündürüyor.

Ya da tamamen başka bir açıklama olabilir. Belki de Meta, eğitim sürecinde ezberleme sorununu kazara kötüleştiren ince değişiklikler yapmıştır. AI şirketleri bu konuda yorum yapmaktan genellikle kaçınırlar.

Başka bir uzman, bunun tüm popüler kitaplar için geçerli olmadığını söyledi. Bazı popüler kitaplar bu sonucu veriyor, diğerleri vermiyor. Bunun neden olduğunu açıklayan net bir hikaye bulmak zor.

Üç Olası Yasal Teori

- Telifli bir eser üzerinde eğitim yapmak, eğitim sürecinin eserin dijital bir kopyasını oluşturması nedeniyle doğası gereği telif hakkı ihlalidir.

- Eğitim süreci, eğitim verilerinden bilgiyi modele kopyalar, modeli telif hakkı yasası kapsamında türev bir eser haline getirir.

- İhlal, modelin telifli bir eserin bölümlerini üretmesi durumunda gerçekleşir.

Şimdiye kadarki tartışmaların çoğu, AI şirketleri için en tehdit edici olduğu için ilk teoriye odaklanmıştır. Eğer mahkemeler bu teoriyi onaylarsa, çoğu mevcut büyük dil modeli, herhangi bir eğitim verisini ezberlemiş olsun ya da olmasın yasa dışı olacaktır.

AI endüstrisinin, eğitim sürecinde telifli eserleri kullanmanın adil kullanım kapsamında olduğuna dair oldukça güçlü argümanları var. Ancak Llama 3.1 70B'nin Harry Potter'ın büyük kısımlarını ezberlemesi, mahkemelerin bu adil kullanım sorularını nasıl değerlendireceğini etkileyebilir.

Adil kullanım analizinin kilit bir parçası, kullanımın "dönüştürücü" olup olmadığıdır - yani bir şirketin yeni bir şey mi yaptığı yoksa sadece başkalarının çalışmasından mı kar ettiği. Dil modellerinin Harry Potter, diğer popüler fantastik romanlar veya klasik distopya romanı gibi popüler eserlerin önemli bölümlerini "kusma" yeteneği, yargıçların bu adil kullanım argümanlarına daha şüpheyle bakmasına neden olabilir.

Dahası, emsal teşkil eden önemli bir davada, şirketin sisteminin herhangi bir kitaptan asla kısa bir alıntıdan fazlasını döndürmemek üzere tasarlandığı argümanı öne sürülmüştü. AI şirketine karşı açılan davadaki yargıç, bu argümanları Meta'nın argümanlarından ayırmak isterse, Llama'nın Harry Potter'dan birkaç satırdan çok daha fazlasını üretebileceği gerçeğini işaret edebilir.

Yeni çalışma, davalıların bu davalarda anlattığı "biz sadece kelime kalıplarını öğreniriz, bunların hiçbiri modelde görünmez" hikayesini karmaşıklaştırıyor. Ancak Harry Potter sonucu, Meta için ikinci teori altında daha da büyük bir tehlike yaratıyor - yani Llama'nın kendisinin kitabın türev bir kopyası olması.

Bir uzman, Harry Potter ve çeşitli diğer kitapların önemli kısımlarını modelden çıkarmanın mümkün olduğunun açık olduğunu söyledi. Bu, muhtemelen bazı kitaplar için, yasanın kitabın bir parçasının modelin kendisinde bir kopyası olarak adlandıracağı bir şey olduğunu düşündürüyor. AI şirketleri, genellikle veri tabanlarını kullanıcıların indirmesine izin vermedikleri için bu tür bir yasal teoriye karşı daha savunmasız olabilirler. Llama gibi modellerin ağırlıklarının (eğer açık kaynaklıysa) erişilebilir olması durumu karmaşıklaştırır.

Prensip olarak, Meta, Harry Potter'ın yüzde 42'sini kopyalamanın, yargıç tarafından oluşturulan esnek adil kullanım doktrini kapsamında izin verildiğine bir yargıcı yine de ikna edebilir. Ancak bu, zorlu bir mücadele olurdu.

Uzmanlar, yapılması gereken adil kullanım analizinin sadece "eğitim seti adil kullanım mı" değil, "modeldeki dahil etme adil kullanım mı" olduğunu belirtti. Bu, davalıların hikayesini karmaşıklaştırıyor.

Araştırmacılar ayrıca, bu araştırmanın açık kaynaklı modelleri kapalı kaynaklı olanlardan daha büyük yasal tehlikeye atabileceği tehlikesinin olduğunu da dile getirdiler. Üniversite araştırmacılarının çalışmalarını yapabilmesinin nedeni, temel modele -ve dolayısıyla kelime dizileri için olasılıkların verimli bir şekilde hesaplanmasına olanak sağlayan kelime olasılığı değerlerine- erişimleri olmasıydı.

Önde gelen laboratuvarların çoğu, bu tür verilere erişimi giderek kısıtladı ve bu modelleri incelemeyi daha zor hale getirdi.

Ayrıca, bir şirket model ağırlıklarını kendi sunucularında tutuyorsa, ihlal edici çıktıların dış dünyaya ulaşmasını engellemek için filtreler kullanabilir. Bu nedenle, temel kapalı modellerin Llama 3.1 70B ile aynı şekilde telifli eserleri ezberlemiş olsa bile, şirket dışındaki herhangi birinin bunu kanıtlaması zor olabilir.

Kısacası, telif hakkı yasası, şirketleri açık kaynaklı modeller yayınlamaktan caydırmak için güçlü bir teşvik yaratabilir.

Bir uzman, bunun bir tür terslik olduğunu ve bu sonuçtan hoşlanmadığını belirtti. Öte yandan, yargıçlar açık kaynaklı modeller yayınlayan şirketleri etkili bir şekilde cezalandırmanın kötü olacağı sonucuna varabilirler.

Başka bir uzman, açık olmak ve ağırlıkları paylaşmanın bir tür kamu hizmeti olduğunu söyledi. Dürüst olmak gerekirse, yargıçların açık kaynaklı modeller sağlayan Meta ve diğerlerine daha az şüpheyle bakabileceğini görebildiğini ekledi.