Intel, Project Battlematrix iş istasyonları için ilk yazılım güncellemesini duyurdu. Bu yeni güncelleme ile Intel'in Arc Pro B serisi GPU'ları, yapay zeka iş yüklerinde önemli performans artışları sağlayacak. Özellikle LLM Scaler 1.0 yazılımı, yapay zeka çıkarım (inference) süreçlerini optimize etmek üzere tasarlandı.

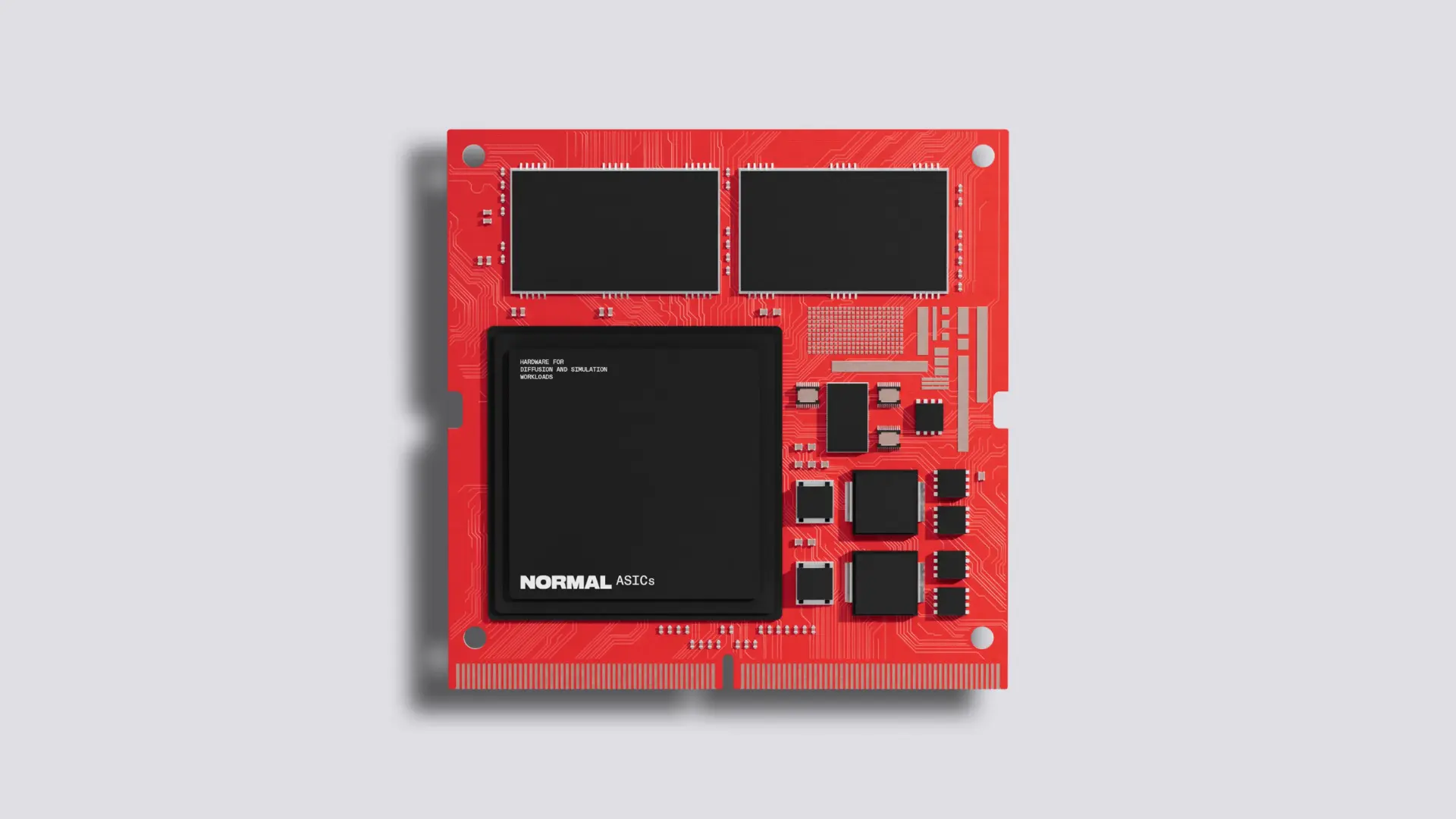

Intel'in yapay zeka odaklı girişimi olan Project Battlematrix, piyasaya yönelik güçlü Intel tabanlı yapay zeka iş istasyonları sunmayı hedefliyor. Bu proje kapsamında Intel donanım ve yazılımı bir araya gelerek, tek bir sistemde birden fazla Arc Pro B serisi GPU kullanan bütünleşik iş istasyonu çözümleri oluşturuluyor. Project Battlematrix iş istasyonları, Xeon işlemciler, sekiz adede kadar GPU ve toplamda 192 GB'a kadar VRAM ile birlikte geliyor. Bu yapay zeka iş istasyonlarının fiyatları ise 5.000 ila 10.000 dolar arasında değişiyor.

Bu sistemlerin kalbinde, Intel'in Arc B580'in iş istasyonu versiyonu olan ve daha fazla belleğe sahip olan Arc Pro B60 yer alıyor. Pro B60, 20 Xe Çekirdeği, 24 GB GDDR6 bellek, 160 XMX motoru, PCIe 5.0 desteği, çoklu GPU desteği ve değişken bir TDP (120 ila 200 watt arası) sunuyor.

Project Battlematrix iş istasyonlarını destekleyen çözüm, sunucuları hızlı ve kolay bir şekilde çalışır duruma getirmek için gereken her şeyi içeren, doğrulanmış, tam yığın konteynerleştirilmiş bir Linux çözümü olacak. LLM Scaler, Intel'in tam yığın konteynerleştirilmiş Linux çözümü için geliştirdiği çeşitli konteynerlerden sadece biri.

LLM Scaler Sürüm 1.0, öncelikli olarak erken müşteri kullanımlarını hedefliyor ve çeşitli yapay zeka modelleri için optimizasyonlar ile spekülatif kod çözme ve torch.compile gibi özellik desteği sunuyor. Sürüm 1.0'a on adet optimizasyon ve özellik eklenmiş durumda.

Özellikle uzun girdi uzunluklarında, 32 milyar parametreli modellerde 40K sıralı uzunluklarda 1.8 kata kadar, 70 milyar parametreli modellerde ise 40K sıralı uzunluklarda 4.2 kata kadar daha hızlı performans elde ediliyor. Ayrıca sekiz milyar ile 32 milyar parametreli modeller için %10'luk bir çıktı verimliliği performansı iyileştirmesi de yapıldı.

LLM'ler için GPU bellek gereksinimlerini azaltmak amacıyla katman bazlı çevrimiçi niceleme (quantization) özelliği eklendi. Bunun yanı sıra, gömme (embedding) ve yeniden sıralama (rerank) modeli desteği, geliştirilmiş çoklu model desteği, maksimum uzunluk otomatik algılama ve veri paralelizmi gibi özellikler de spekülatif kod çözme ve torch.compile ile birlikte sunuluyor.

Intel ayrıca, daha fazla işlevselliğe sahip güçlendirilmiş bir LLM Scaler sürümünün üçüncü çeyrek sonunda yayınlanacağını, tam özellikli sürümün ise dördüncü çeyrekte yayınlanmasının planlandığını açıkladı. LLM Scaler teknik olarak planlanandan önce yayınlanmış oldu; Intel daha önce ilk konteyner dağıtımlarının üçüncü çeyrekte geleceğini belirtmişti.

Intel, dördüncü çeyrekte SRIOV, VDI ve yönetim yazılımı dağıtımı gibi ek özelliklerin de geleceğini taahhüt etti.