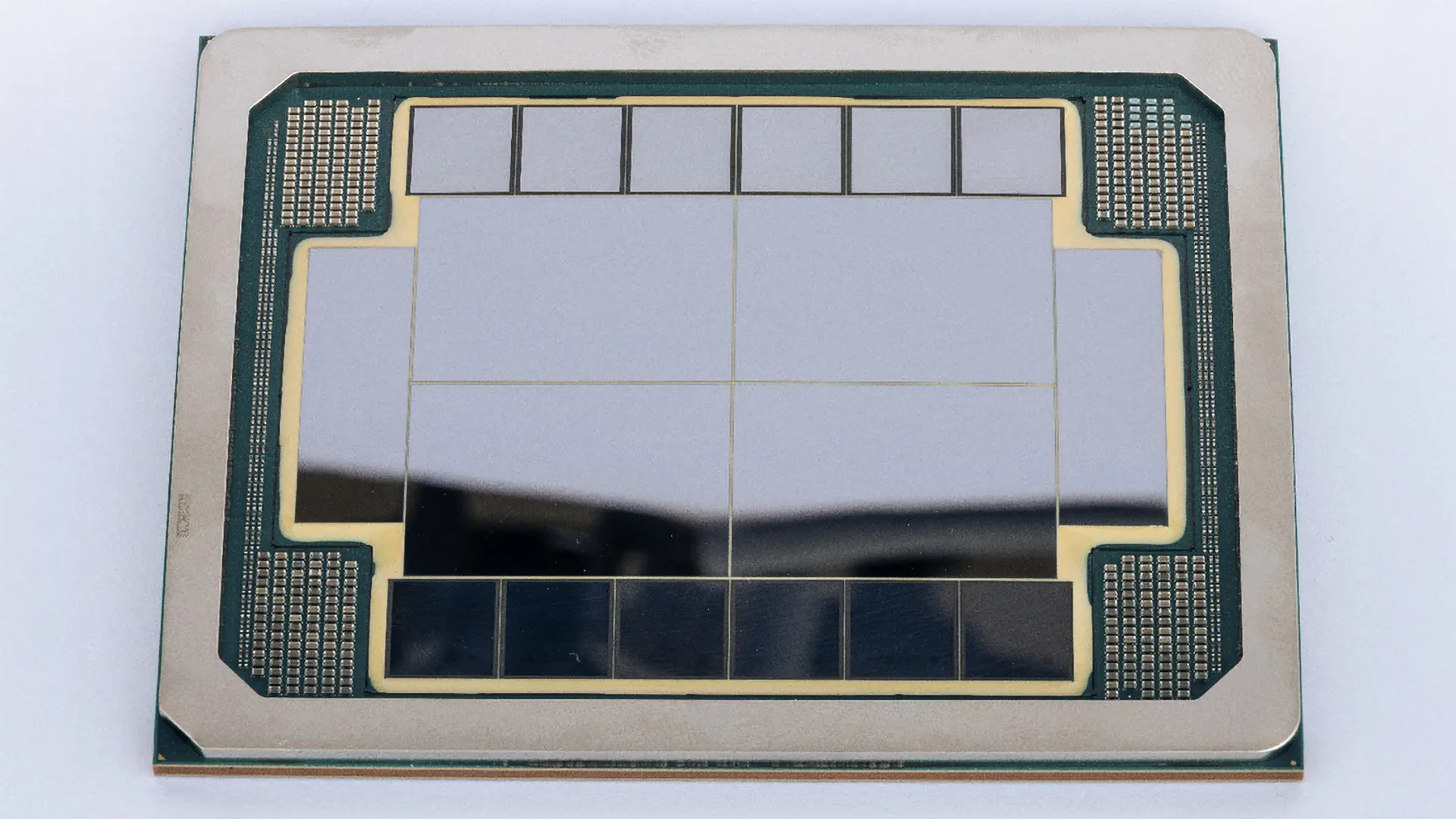

Yapay zeka alanında faaliyet gösteren büyük şirketler, kullandıkları veya gelecekte kullanmayı planladıkları GPU sayılarıyla sıkça gündeme geliyor. Son olarak, 50 milyon adet H100 eşdeğeri yapay zeka işlem gücüne ulaşma hedefiyle Elon Musk'ın şirketi xAI, bu alandaki devasa planlarını duyurdu. Bu hedef, mevcut teknolojilerin ötesinde bir hesaplama kapasitesi vaat ediyor.

Yapay Zeka Eğitimi İçin 50 ExaFLOPS Hesaplama Gücü

Elon Musk, yaptığı bir sosyal medya paylaşımında, xAI'nin önümüzdeki beş yıl içinde 50 milyon adet H100 eşdeğeri yapay zeka işlem gücünü aktif hale getirmeyi amaçladığını belirtti. Bu hedef, H100 GPU'ların 1000 FP16/BF16 TFLOPS civarında bir performans sunduğu göz önüne alındığında, 2030 yılına kadar yapay zeka eğitimi için 50 FP16/BF16 ExaFLOPS'luk bir hesaplama kapasitesi anlamına geliyor. Mevcut performans artış eğilimleri dikkate alındığında, bu hedefe önümüzdeki beş yıl içinde ulaşmak oldukça mümkün görünüyor.

650 Bin Gelecek Nesil GPU Yeterli Olabilir mi?

Nvidia'nın ve diğer şirketlerin GPU'larının eğitim performansını artırma hızının devam edeceği varsayımıyla, yaklaşık 1.3 milyon GPU ile 2028'de veya 650 bin adet GPU ile 2029'da 50 ExaFLOPS'luk hedefe ulaşmak mümkün olabilir. Eğer xAI, Nvidia donanımlarına yeterli bütçeyi ayırabilirse, bu hedefe daha erken varması da olası. xAI, en yeni yapay zeka GPU hızlandırıcılarını en hızlı şekilde konuşlandıran şirketlerden biri olarak öne çıkıyor. Şirket, Hopper mimarisine dayanan 200 bin H100 ve H200 hızlandırıcı ile Blackwell mimarisine dayanan 30 bin GB200 birimini zaten çalıştırıyor. Ayrıca, önümüzdeki haftalarda ilk düğümlerin aktif hale gelmesi beklenen ve her biri iki GPU içeren 550 bin GB200 ve GB300 düğümünden oluşan Colossus 2 kümesini inşa etmeyi hedefliyor.

Sürekli Performans Artışları ve Enerji Tüketimi

Nvidia'nın yeni yapay zeka hızlandırıcılarını yıllık olarak piyasaya sürme stratejisi, önemli performans artışları sağlıyor. Örneğin, Nvidia'nın Blackwell B200'ünün, 2016'daki Pascal P100'e kıyasla 20.000 kat daha yüksek çıkarım performansı sunduğu iddia ediliyor. Bu tür gelişmeler, yapay zeka alanındaki ilerlemenin hızını gösteriyor. Ancak bu devasa hesaplama gücünün enerji tüketimi de büyük bir soru işareti yaratıyor. Bir H100 GPU'nun 700W enerji tükettiği düşünüldüğünde, 50 milyon GPU'luk bir kümenin 35 gigawatt (GW) gibi devasa bir güç tüketimine ulaşması bekleniyor. Bu miktar, yaklaşık 35 nükleer santralin ürettiği güce eşdeğer ve günümüz şartlarında böyle bir veri merkezini beslemek pek gerçekçi görünmüyor. Gelecek nesil GPU'ların enerji verimliliğini artırması beklenmekle birlikte, bu devasa hedefin enerji ihtiyacını karşılamak önemli bir zorluk olmaya devam ediyor.