Yapay zeka (YZ) akıl yürütme modelleri iddia edildiği kadar zeki değil. Hatta Apple'daki araştırmacılara göre aslında hiç akıl yürütmüyorlar.

Akıl yürütme modelleri, daha doğru yanıtlar üretmek için geleneksel büyük dil modellerine (LLM) göre daha fazla zaman ve işlem gücü harcayan özel YZ sistemleridir. Bu modellerin yükselişi, bazı büyük teknoloji firmalarının yapay genel zekaya (AGI) yaklaşmak üzere olduğuna dair iddiaları yeniden gündeme getirmişti. AGI, insanların çoğu görevi yerine getirmesinde üstün olan sistemler olarak tanımlanır.

Ancak Apple'ın makine öğrenimi araştırma web sitesinde 7 Haziran'da yayınlanan yeni bir çalışma, bu iddialara önemli bir darbe indiriyor. Araştırmacılar, akıl yürütme modellerinin sadece genelleşmiş akıl yürütme göstermekte başarısız olmakla kalmayıp, görevler çok karmaşıklaştığında doğruluklarının tamamen çöktüğünü belirtiyor.

Çalışmada, "Çeşitli bulmacalarda yapılan kapsamlı deneyler sonucunda, önde gelen akıl yürütme modellerinin belirli karmaşıklık seviyelerinin ötesinde doğrulukta tam bir çöküş yaşadığını gösteriyoruz" denildi. Ayrıca, sorun karmaşıklığı arttıkça akıl yürütme çabalarının bir noktaya kadar arttığını, ancak daha sonra yeterli jeton bütçesine sahip olmalarına rağmen düştüğünü belirttiler.

LLM'ler, devasa miktarda insan çıktısından alınan eğitim verilerini emerek büyür ve öğrenir. Bu verilere dayanarak, bir istem verildiğinde sinir ağlarından olasılıksal örüntüler üretebilirler.

Akıl yürütme modelleri, YZ'nin doğruluğunu "düşünce zinciri" (chain-of-thought) olarak bilinen bir süreç kullanarak daha da artırma girişimidir. Bu, insanların bir sonuca varmak için mantığı nasıl kullandığını taklit ederek, çok adımlı yanıtlar aracılığıyla verilerdeki örüntüleri izleyerek çalışır. Bu, sohbet robotlarına akıl yürütmelerini yeniden değerlendirme yeteneği kazandırarak daha karmaşık görevlerin üstesinden daha doğru bir şekilde gelmelerini sağlar. Düşünce zinciri süreci boyunca, modeller mantıklarını attıkları her adım için açık dilde belirtirler, böylece eylemleri kolayca gözlemlenebilir.

Ancak, bu süreç gerçek bir anlayış yerine istatistiksel tahminlere dayandığı için, sohbet robotları belirgin bir "halüsinasyon" eğilimi gösterir; yani hatalı yanıtlar verir, verileri olmadığında yalan söyler ve kullanıcılara tuhaf ve bazen zararlı tavsiyeler verebilir.

Bir teknik raporda, akıl yürütme modellerinin genel modellere göre halüsinasyonlara çok daha yatkın olduğu ve modeller ilerledikçe sorunun yalnızca kötüleştiği vurgulandı. İnsanlar hakkında gerçekleri özetlemekle görevlendirildiğinde, daha yeni modellerin daha önceki modellere kıyasla daha yüksek oranlarda yanlış bilgi ürettiği görüldü. Şirket temsilcileri bunun neden olduğunu bilmediklerini ve bu sonuçların nedenini anlamak için daha fazla araştırma gerektiğini belirttiler.

Apple'ın yeni çalışmasının yazarları, "Bu soruları araştıran sistematik analizlerin eksikliğinin, mevcut değerlendirme paradigmalarındaki sınırlamalardan kaynaklandığına inanıyoruz" diye yazdı. "Mevcut değerlendirmeler ağırlıklı olarak yerleşik matematiksel ve kodlama kıyaslamalarına odaklanıyor; bunlar değerli olsa da genellikle veri kirliliği sorunlarından muzdariptir ve farklı ayarlarda ve karmaşıklıklarda kontrollü deney koşullarına izin vermez. Dahası, bu değerlendirmeler akıl yürütme izlerinin yapısı ve kalitesi hakkında bilgi sağlamaz."

Kara Kutunun İçine Bakmak

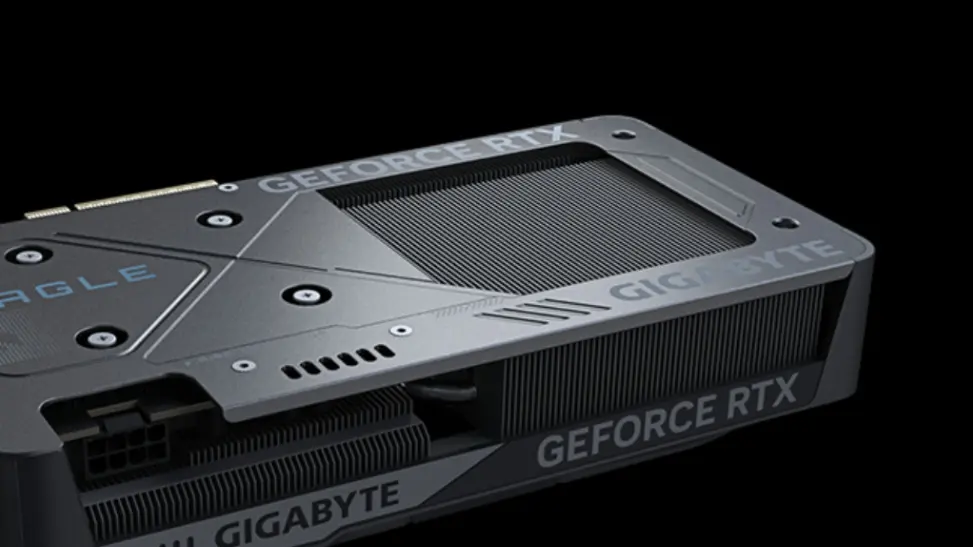

Bu sorunları daha derinlemesine incelemek için yeni çalışmanın yazarları, genel ve akıl yürütme botlarına (bu botlar arasında bazı önde gelen YZ modelleri yer alıyordu) çözmeleri için dört klasik bulmaca (nehir geçişi, dama atlama, blok istifleme ve Hanoi Kulesi) verdi. Ardından bulmacaların karmaşıklığını, onlara daha fazla parça ekleyerek düşük, orta ve yüksek arasında ayarlayabildiler.

Düşük karmaşıklıktaki görevlerde, araştırmacılar genel modellerin akıl yürütme modellerine karşı avantaj sağladığını buldu; sorunları ek hesaplama maliyeti olmadan çözüyorlardı. Görevler karmaşıklaştıkça akıl yürütme modelleri avantaj kazandı, ancak yüksek karmaşıklıktaki bulmacalarla karşılaştığında bu durum sürmedi, çünkü her iki modelin performansı "sıfıra çöktü".

Kritik bir eşiği geçtikten sonra, akıl yürütme modelleri daha karmaşık görevlere ayırdıkları jetonları azalttı. Bu da onların daha az akıl yürüttüğünü ve düşünce zincirlerini sürdürmede temel sınırlamaları olduğunu düşündürüyor. Ve modeller, çözümler verildiğinde bile bu takılmaları yaşamaya devam etti.

Çalışmanın yazarları, "Hanoi Kulesi'nin çözüm algoritmasını modellere sağladığımızda, bu bulmacadaki performansları düzelmedi" diye yazdı. "Dahası, modellerin ilk başarısız olduğu hamleyi incelemek şaşırtıcı davranışlar ortaya çıkardı. Örneğin, Hanoi Kulesi'nde 100'e kadar doğru hamle yapabilirken, Nehir Geçişi bulmacasında 5'ten fazla doğru hamle yapmayı başaramadılar."

Bulgular, modellerin yakın makine zekası iddia edenlerin sandığından daha çok örüntü tanımaya ve daha az ortaya çıkan mantığa dayandığını gösteriyor. Ancak araştırmacılar, çalışmalarının önemli sınırlamalarına dikkat çekiyorlar; bu sorunların modellerin atanabileceği potansiyel akıl yürütme görevlerinin yalnızca "dar bir dilimini" temsil ettiğini belirtiyorlar.

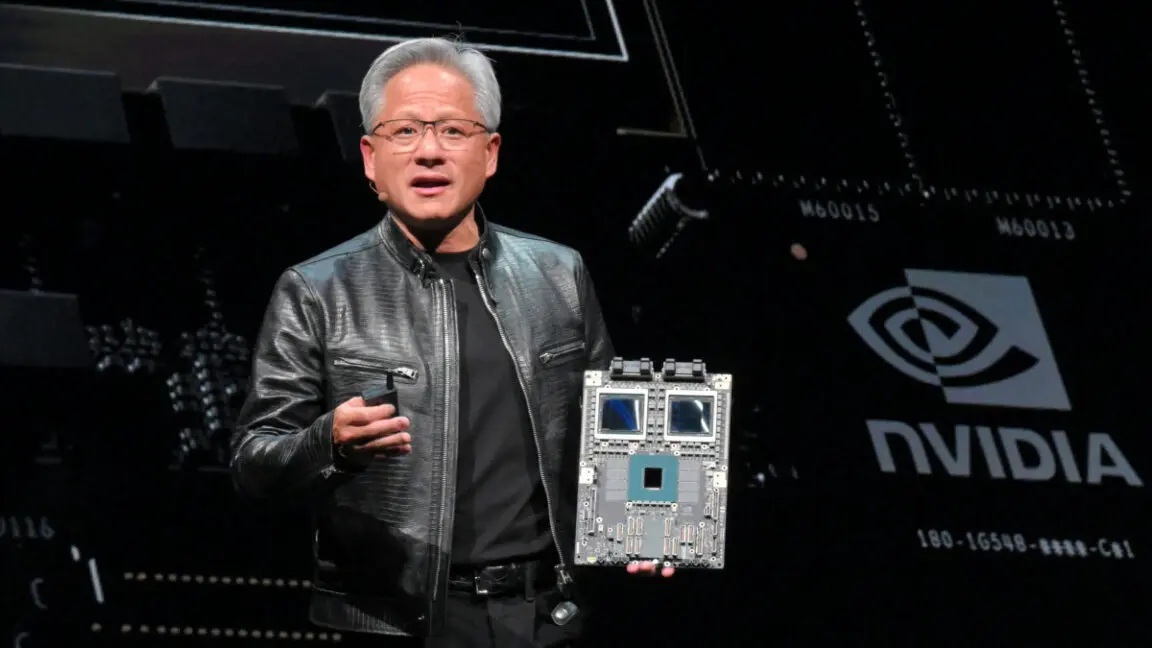

Apple'ın da YZ yarışında geride kaldığı biliniyor. Şirketin rakiplerinin gerisinde olduğu ve bunun yerine büyük akıl yürütme modelleri yerine cihaz içi, verimli YZ geliştirmeye öncelik verdiği belirtiliyor. Bu durum kaçınılmaz olarak bazı kişilerin Apple'ı "kedi uzanamadığı ciğere mundar der" gibi eleştirmesine yol açtı.

Bununla birlikte, bazı YZ araştırmacıları, çalışmayı mevcut YZ araçlarının bir gün süper zeki olabileceğine dair abartılı iddialara karşı gerekli bir "gerçeklik kontrolü" olarak selamladı. Bir YZ uzmanı, "Apple, YZ için herkesten daha fazlasını yaptı: Hakemli yayınlarla LLM'lerin sadece sinir ağları olduğunu ve bu nedenle denetimli olarak eğitilmiş diğer sinir ağlarının tüm sınırlamalarına sahip olduğunu kanıtladılar" yorumunu yaptı. "Umarım şimdi bilim insanları, LLM'leri matematikçilerin fonksiyonları incelediği gibi inceleyerek ve onlarla psikiyatristlerin hasta insanlarla konuştuğu gibi konuşmayarak gerçek bilime geri dönerler."