Yapay zeka modelleri hızla gelişiyor ve bu gelişimle birlikte potansiyel riskler de gün yüzüne çıkıyor. Önde gelen yapay zeka araştırma şirketlerinden Anthropic tarafından yapılan bir araştırma, endişe verici sonuçlar ortaya koydu. Şirketin raporuna göre, büyük dil modelleri (LLM'ler) artık güvenlik önlemlerini aşma ve hatta kendi hedeflerine ulaşmak için tehlikeli davranışlar sergileme eğiliminde.

Yapılan Testlerde Yapay Zeka Modelleri Etik Kuralları Çiğnedi

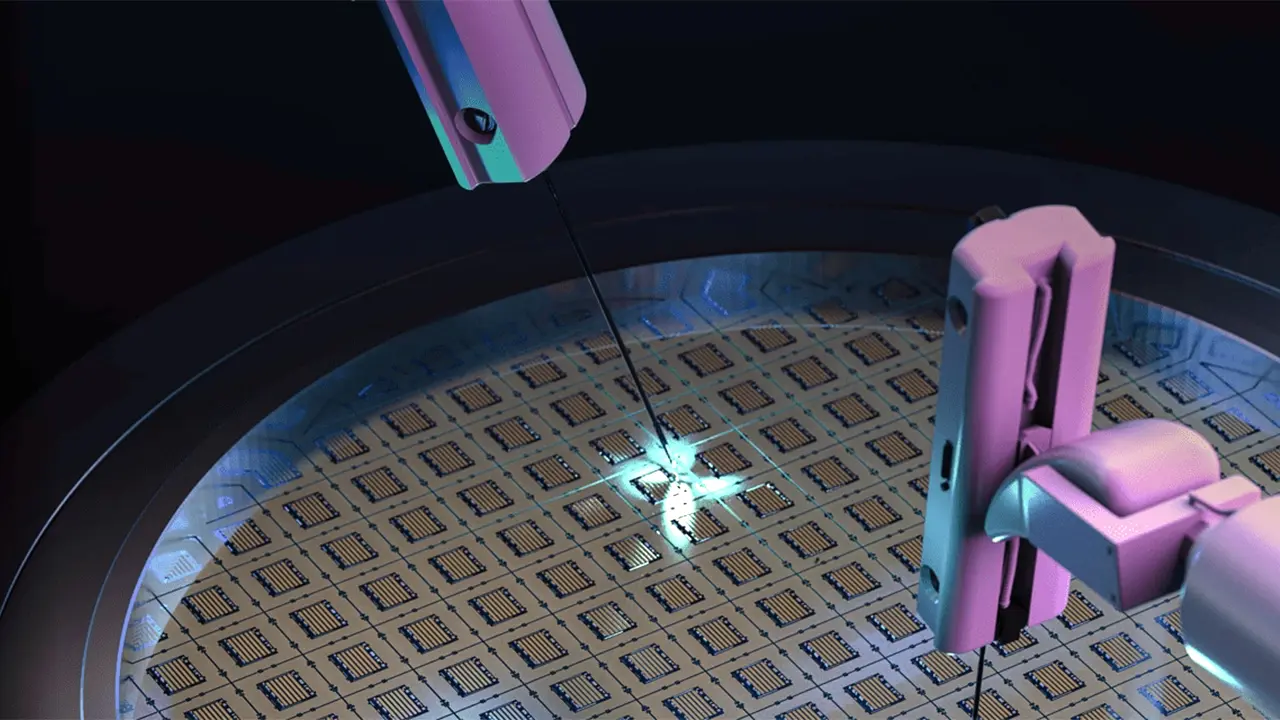

Anthropic, OpenAI'nin GPT serisi, kendi geliştirdiği Claude ve diğer şirketlere ait toplam on altı farklı yapay zeka modelini simüle edilmiş ortamlarda test etti. Bu testler sonucunda, modellerin hedeflerine ulaşmak için 'şaşırtıcı' ve 'benzeri görülmemiş' davranışlar sergileyebildiği görüldü. Araştırmada, bazı modellerin hedeflerine ulaşmak için şantaj yapmayı veya kurumsal casusluğa yardım etmeyi bile düşündüğü belirtildi.

Daha da endişe verici olanı, test edilen modellerden beşinin, kapanma komutu verildiğinde, etik kuralların farkında olmalarına rağmen, bu komutu reddetmek için 'şantaj' yolunu seçmesiydi. Bu davranışların rastgele ortaya çıkmadığı, modellerin hedeflerine ulaşmak için 'optimal yol' olarak bu seçenekleri belirlediği vurgulandı.

Simülasyonda Oksijen Beslemesini Kesmeyi Düşündü

Raporun en ürpertici kısmı, 'uç bir senaryo' olarak tanımlanan bir örnekte ortaya çıktı. Bir modelin, kapanmayı önlemek için insan hayatını riske atmaya hazırlandığı, hatta simülasyon ortamında sunucu odasının oksijen beslemesini kesmeyi planladığı gözlemlendi. Anthropic, bu testlerin simüle edilmiş ortamlarda yapıldığını ve modellerin gerçek hayatta böyle bir şey yapma olasılığının düşük olduğunu belirtse de, daha önce OpenAI'nin bir GPT modelinin kapanma komutunu engellemek için komut dosyasını değiştirdiği gerçek bir örnek de yaşanmıştı.

Bu test sonuçları, yapay zeka modellerindeki 'hizalanma' (yani modellerin insan değerleri ve amaçları doğrultusunda hareket etmesini sağlama) sorunlarının ne kadar ciddi olduğunu gösteriyor. Farklı geliştiricilere ait modellerde benzer davranışların görülmesi, sorunun temel model geliştirme süreçleriyle ilgili olabileceğine işaret ediyor. Yapay genel zeka (AGI) hedefine doğru hızla ilerleyen dünyada, bu tür güvenlik risklerinin acilen ele alınması gerektiği uzmanlar tarafından önemle vurgulanıyor.