Alibaba Cloud, geliştirdiği yeni Aegaeon havuzlama sistemi sayesinde yapay zeka modelleri için kullanılan Nvidia GPU sayısında önemli bir düşüş elde ettiğini duyurdu. Çok aylık bir beta testi sürecinde, sistemin Nvidia GPU ihtiyacını %82 oranında azalttığı belirtildi. Bu yenilik, özellikle Çin gibi Nvidia'nın son teknoloji H20 GPU'larına erişimin sınırlı olduğu pazarlarda, bulut sağlayıcıların mevcut donanımlardan daha fazla çıkarım (inference) kapasitesi elde etmesini sağlayabilir.

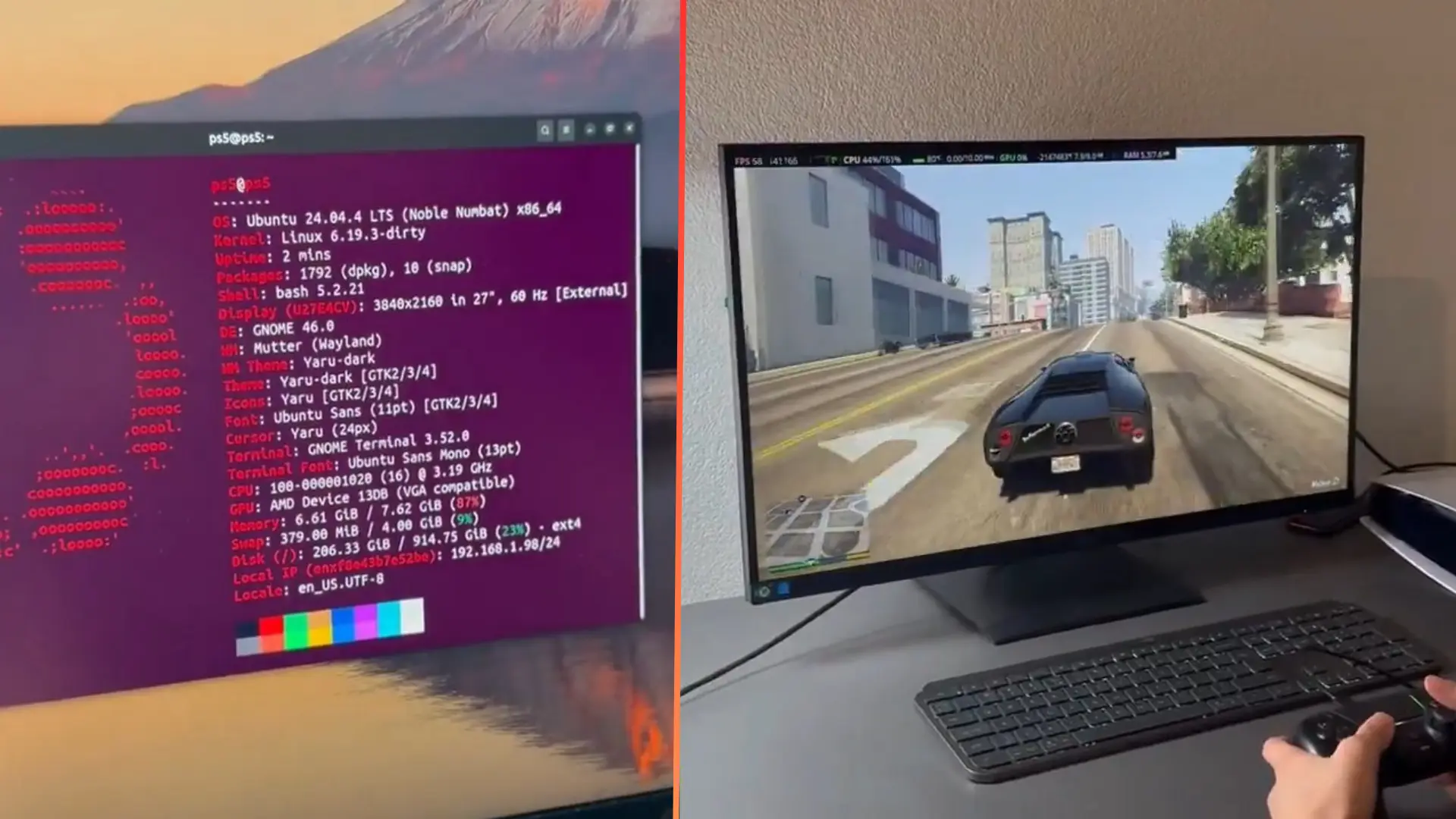

Aegaeon, modellerin kalitesini veya hızını artıran eğitim odaklı gelişmelerden farklı olarak, özellikle ani veya öngörülemeyen talepler karşısında GPU kullanımını en üst düzeye çıkarmak üzere tasarlanmış bir çıkarım zamanı zamanlayıcısıdır. Sistem, bir hızlandırıcıyı tek bir modele sabitlemek yerine, GPU erişimini jeton (token) seviyesinde sanallaştırır. Bu sayede, küçük iş parçacıklarını paylaşılan bir havuz üzerinden zamanlayabilir. Böylece, tek bir H20 GPU'su birden fazla farklı modeli eşzamanlı olarak çalıştırabilir ve sistem genelinde "iyi verim" (goodput) adı verilen etkili çıktı ölçümü, eski sunucusuz sistemlere kıyasla dokuz kata kadar artırılabilir.

Yayınlanan bir bilimsel makaleye göre, sistem aylarca üretim ortamında test edildi. Makalede, Pekin Üniversitesi ve Alibaba'nın altyapı departmanından yazarların imzası bulunuyor. Bu testler sırasında, 72 milyar parametreye kadar farklı ölçeklerdeki onlarca büyük dil modelini (LLM) desteklemek için gereken GPU sayısı 1.192'den sadece 213'e düştü.

Makalede, hangi modellerin tasarrufa en çok katkı sağladığına dair ayrıntılı bir döküm bulunmasa da, yapılan bazı haberlere göre bu testlerin Nvidia'nın H20 GPU'ları kullanılarak gerçekleştirildiği belirtiliyor. Bu GPU'lar, mevcut ABD ihracat kontrolleri kapsamında Çin'deki alıcılar için yasal olarak erişilebilen az sayıdaki hızlandırıcıdan biri.

Alibaba'ya göre bu kazanımlar iki ana teknikten kaynaklanıyor: GPU başına birden fazla modelin paketlenmesi ve çıktı üretildikçe hesaplama gücünü dinamik olarak tahsis eden jeton seviyesinde otomatik ölçeklendirme kullanılması. Karşılaştırmalı testlerde Aegaeon'un, sunucusuz sistemlere kıyasla %50 ila %800 arasında daha iyi verim sağladığı görülüyor.

Bu tasarrufların Alibaba'nın kendi sistemi dışına ne kadar yansıyacağı henüz belirsiz. Alibaba Cloud'un makalesinde beta testinde kullanılan ağ altyapısının tam detayları belirtilmese de, şirketin kendi eRDMA tabanlı ağ çözümlerine sahip olduğu ve son derece entegre GPU sunma yığınları oluşturma konusunda bir geçmişe sahip olduğu biliniyor. Bu durum, sonuçların optimize edilmiş, dikey olarak entegre bir ortama bağlı olabileceğini düşündürüyor.

Bununla birlikte, çıkarım talebinin artmaya devam ettiği bir dönemde, bu sonuçların kıt hızlandırıcı filolarını daha verimli kullanmak isteyen diğer büyük bulut sağlayıcıları tarafından ilgiyle karşılanması bekleniyor.